华为诺亚方舟实验室最近联合香港大学发了一篇针对”Deep Research Agents”(深度研究代理)的系统性综述,在我的印象中,这是他们第二次发布关于Deep Research的综述论文。上一篇里提供了一个结构导向 (Structure-Oriented) 的视角,核心是“分类”。而今天的这篇论文提供了一个过程导向 (Process-Oriented) 的视角,核心是“流程” 如果您想了解整个领域的格局,知道各个公司推出的产品属于哪个流派,各自有什么优缺点,那么上一篇文章《华为、牛津联手发布万字报告,揭秘OpenAI、谷歌都在秘密布局的“DR代理”》提供了一个全面分析综述和“市场分析报告”。 如果您想自己动手构建一个深度研究代理,那么今天的文章会为您提供一个清晰的“操作手册”或“蓝图”。它告诉您需要实现哪几个功能模块。

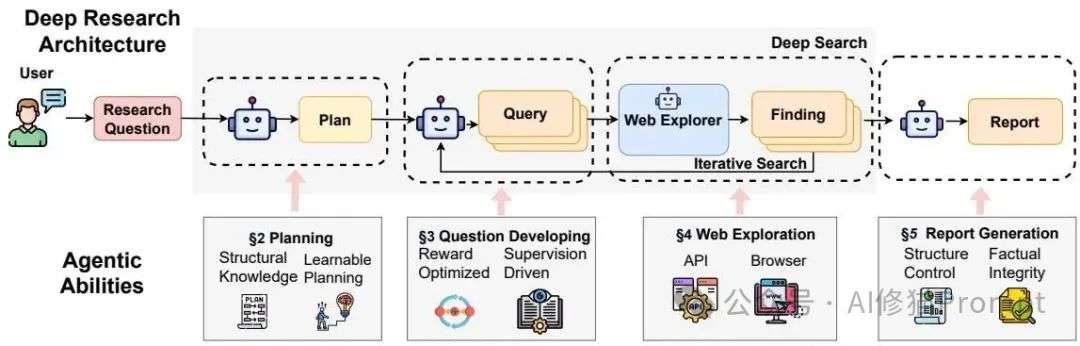

第一步,谋定而后动:一切始于“规划 (Planning)”

这个“规划”阶段就好像AI在真正动手前,给自己画了一张详细的作战地图,它不再是接到一个指令就莽撞地冲出去,而是先冷静地分析这个宏大的研究目标该如何拆解。您也可以看下之前的文章《全面思考,从目标到起点规划,提升LLM规划能力4%至24% |普林斯顿最新》

- 目标:此阶段旨在将用户提出的一个宽泛、高层次的研究问题,分解成一系列结构化的、可执行的子目标或子任务。它需要生成一个明确的路线图来指导后续的信息检索和内容综合。

- 挑战:主要挑战在于如何将模糊或开放性的问题分解成结构化计划,并确保计划的灵活性和可解释性,避免后续执行时出现偏差或错误。

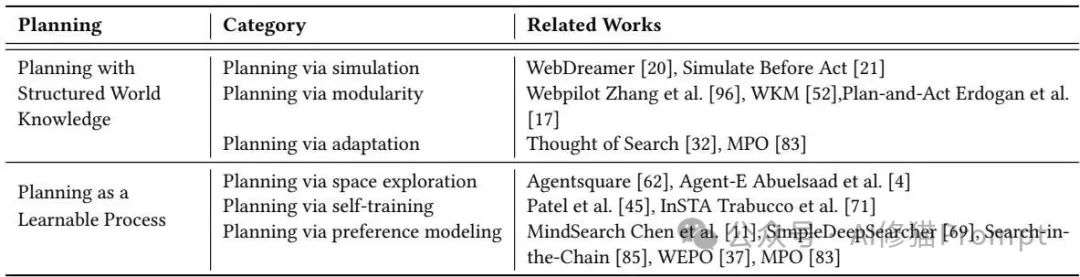

- 方法分类:

- 基于结构化世界知识的规划:利用AI已有的先验知识(比如知识图谱)或通过“模拟推演”来预测不同行动路径的可行性,从而制定更稳健的计划。

- 作为可学习过程的规划:将规划本身视为一个学习任务,让代理通过与环境的互动、反馈(比如强化学习)或大规模训练来持续优化其自身的决策过程。

- 例子:比如,要研究“新能源汽车电池的技术趋势”,它会先规划出“1. 调研当前主流电池类型”、“2. 探索各类电池的技术瓶颈”、“3. 搜集前沿的电池技术论文”等一系列子任务,这整个过程确保了后续所有行动都有的放矢。

第二步,精准发问的艺术:“问题构建 (Question Developing)”

规划好了地图,下一步就是该怎么问路,这就是“问题构建”阶段的核心,它要求AI具备将一个抽象的子目标转化为一连串精准、高效的搜索查询的能力。

- 目标:针对规划阶段产生的每个子目标,生成一个或多个具体的、有针对性的检索查询(Search Queries),以获取最相关的信息。

- 挑战:生成的查询需要在“精确性”和“覆盖面”之间取得平衡,并且能够根据任务进展和已收集信息进行动态调整,避免提出重复或无意义的问题。

- 方法分类:

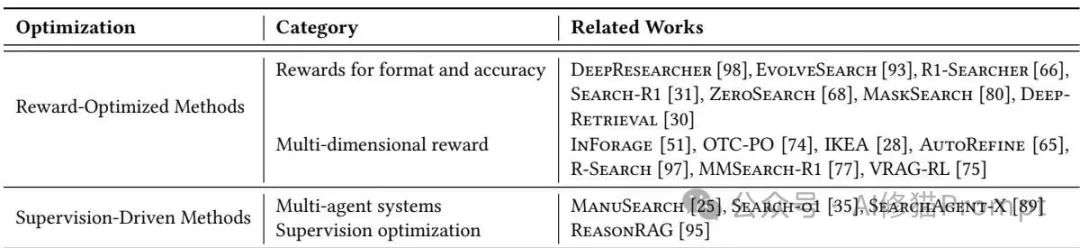

- 奖励优化方法 (Reward-Optimized):主要使用强化学习(RL),让AI像打游戏一样,通过与搜索环境互动并根据结果(如答案准确性)获得奖励,来学习什么样的提问方式“得分”最高。

- 监督驱动方法 (Supervision-Driven):依赖于人工编写的示例或规则进行监督微调,或通过多Agent协作等架构设计来提升查询质量,避免了强化学习的复杂性。

- 例子:针对“调研当前主流电池类型”这个子任务,它可能会生成“三元锂电池 vs 磷酸铁锂电池 优缺点”、“固态电池最新研究进展”、“钠离子电池商业化前景”等多个具体查询。

第三步,上天入地搜集情报:“网页探索 (Web Exploration)”

现在有了高质量的问题,就该去广阔的互联网上寻找答案了,这便是“网页探索”阶段,也是整个流程中信息采集的关键一环。

- 目标:根据生成的查询,高效地从网络上检索最相关、最可信的信息,并过滤掉噪声和冗余内容。

- 挑战:如何在浩瀚的、信息质量参差不齐的互联网中精确定位稀疏分布的有效信息。

- 方法分类:

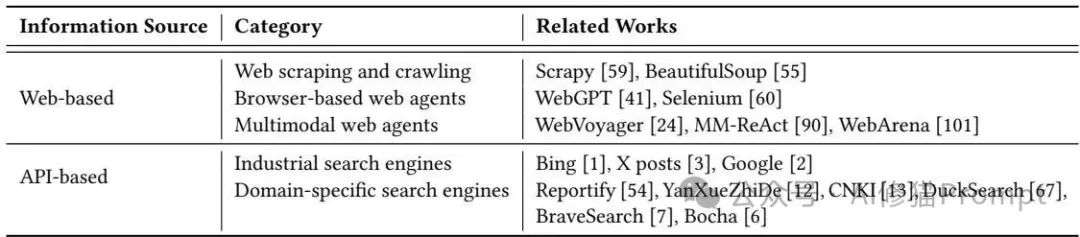

- Web代理驱动 (Web agent-based):打造一个“自主浏览器代理”,这个AI能像人一样真实地点击网页链接、浏览内容、甚至填写表单,它特别适合去挖掘那些隐藏在复杂交互界面后的深层信息。

- API驱动 (API-based):直接调用成熟搜索引擎的API(如Google, Bing),这种方式就像是给AI开了绿色通道,能快速拿到经过初步整理和排序的高质量信息,虽然牺牲了一些灵活性,但胜在高效可靠。

第四步,从碎片到洞见:“报告生成 (Report Generation)”

当AI收集了足够多的情报碎片后,它需要完成最关键的一步“报告生成”,将这些零散的信息整合成一份结构清晰、逻辑严谨、事实准确的研究报告。

- 目标:将前面阶段收集到的碎片化信息,整合成一篇结构连贯、逻辑清晰、内容详实的最终报告,而不仅仅是简单的问答。

- 挑战:这里的核心挑战有两个,一是“结构控制”,如何确保报告不是一堆信息的胡乱堆砌;二是“事实完整性”,如何确保报告中的每一句话都忠于原始信源。

- 方法分类:

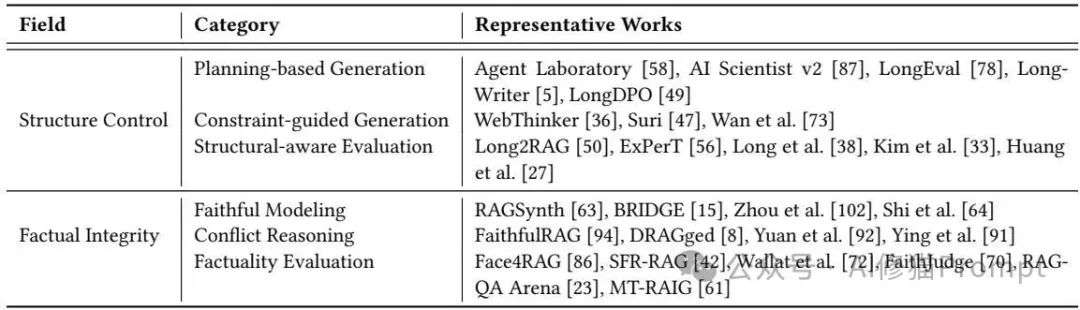

- 结构控制 (Structure Control):通过基于规划的生成(先生成大纲再填充内容)、约束引导的生成(在生成时遵循特定格式要求)等方法来保证报告的条理性和一致性。

- 事实完整性 (Factual Integrity):通过忠实建模(确保生成内容严格基于证据)、冲突推理(处理不同来源信息间的矛盾)和事实性评估(设计指标来衡量生成内容与信源的一- 致性)来减少幻觉。

工作流架构:一个全能天才还是一个专家梦之队?

在具体的系统设计上,研究者们也面临一个经典的选择:我们是该打造一个“单代理”系统,还是一个“多代理”系统?

单代理系统 (Single-Agent Systems)

- 核心定义:由一个单独的、统一的大语言模型(LLM)代理来负责从头到尾的整个研究过程,它就像一个“全能研究员”。

- 工作模式:这种系统的工作流是“一体化(monolithic)”的,代理会顺序地执行任务,所有的推理、决策和状态管理都在这一个模型内部完成。

- 论文提及案例:研究者提到 DeepResearcher、WebThinker 和 Search-R1 等都是这类系统的典型例子。

多代理系统 (Multi-Agent Systems)

- 核心定义:将复杂的深度研究流程分解成多个独立的阶段,并为每个阶段指派一个专门的代理来负责,这就像一个各司其职的“研究团队”。

- 工作模式:这种系统是“模块化(modular)”的,不同的代理扮演不同的角色,例如:

- 规划者代理 (Planner agents):负责任务分解和制定研究计划。

- 查询者代理 (Query agents):专注于生成高质量的搜索查询。

- 检索者代理 (Retriever agents):负责与外部工具交互,收集证据。

- 写作者代理 (Writer agents):负责将信息整合成结构化的报告。

- 论文提及案例:研究者提到 AgentRxiv、AI Scientist 和 OpenResearcher 等系统采用了这种协作模式。

关键过程:如何训练和评估这些聪明的代理?

您可能会问,这么复杂的系统该如何优化和评估呢?论文同样对此进行了梳理,这对于我们工程师来说至关重要。

参数优化 (Parameter Optimization):

- 对比学习 (Contrastive Learning):通过向模型展示成功和失败的案例(比如好的工具使用方式和坏的使用方式),让模型学会明辨是非。

- 强化学习 (Reinforcement Learning):为代理设定一个长远目标(比如最终报告的质量),并给予奖励,让它在不断的试错中学习如何更好地规划和决策。

- 课程学习 (Curriculum Training):像人类学习一样,先让代理掌握一些基础技能,然后再逐步挑战更复杂的完整研究任务,稳扎稳打。

基准测试与评估 (Benchmark and Evaluation)

- 评估什么:为了客观评价深度研究代理的能力,研究者们设计了专门的基准测试集。

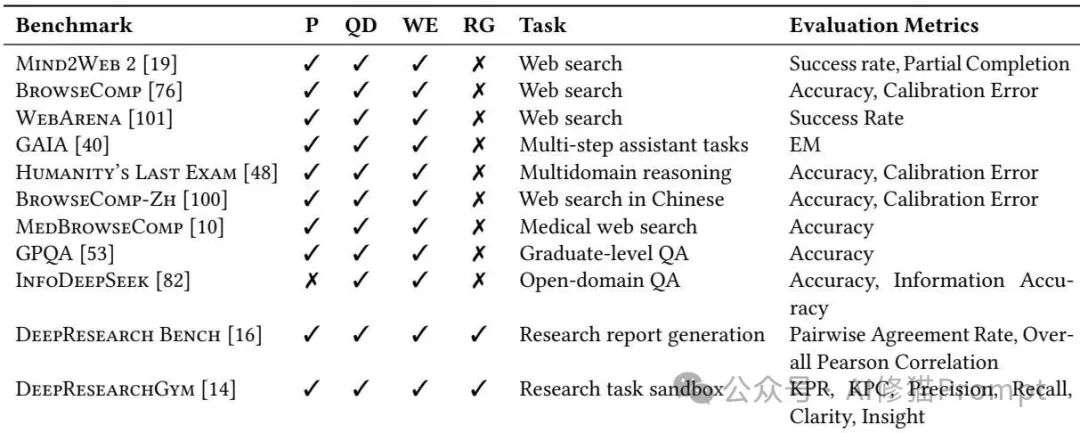

- 两类基准:面向搜索的基准:如 MIND2WEB 2,主要评估代理在信息检索和网页浏览任务中的表现。

- 面向研究的基准:如 DEEPRESEARCH BENCH,则更为全面,它会评估从规划到最终报告生成的整个流程,包括报告的知识准确率、引用召回率等。

下一步去哪?我们面临的真实挑战与未来

深度研究代理的探索之路才刚刚开始,它还远非完美,研究者们指出了几个亟待解决的硬骨头。首先,现实世界的研究远不止网页搜索,AI需要学会使用更多的工具,比如查询数据库、调用API、甚至分析代码;其次,事实性依然是悬在头顶的达摩克利斯之剑,如何在一个充满矛盾和虚假信息的网络环境中保证100%的准确性,是一个巨大的挑战。未来的方向也同样令人兴奋,比如让AI能够理解图表、PDF等多模态信息,或者为每一位用户打造一个懂得其偏好和习惯的个性化研究助理,这些都将是您我这样的工程师大展拳脚的领域。

文章来自于微信公众号“AI修猫Prompt”。