最近,看到各大厂商,在不断地将自己的AI大模型进行开源。

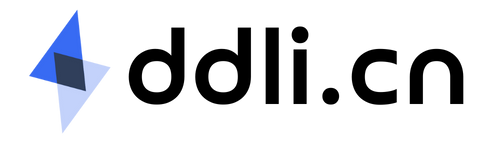

华为宣布开源:盘古7B稠密和72B混合专家模型。

百度正式宣布开源文心一言大模型 4.5 系列的 10 款模型。

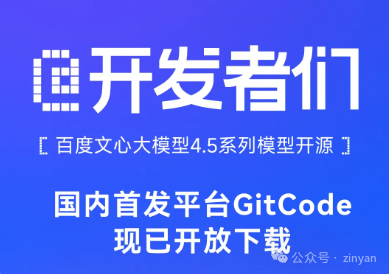

腾讯的混元也有模型进行开源。

阿里的通义千问也有大量模型开源

除了国内的各大主流厂商在不断的开源自身研发的AI大模型以外,国外的开源也是热火朝天。例如Google的Gemma系列进行了开源,亚马逊的开源模型Falcon 40B,Meta开源的Llama系列模型等等。

大模型花费了多少钱?

国内没有哪家公司明确地公布了大模型的研发成本。我们从很早上线的文心一言来预估一下。 毕竟李彦宏也是曾经第一个说开源模型会越来越落后。结果现在选择开源了文心一言大模型。

财报显示,2019 年至 2024 年,百度的研发费用分别为 183.5 亿元、195.1 亿元、249.4 亿元、233.2 亿元、241.9 亿元和 221.3 亿元,近 4 年的研发费用均超过 220 亿元。

在文心一言推出后,2023 年第二季度,百度研发费用为 64 亿元,同比增长 1%,主要是由于支持文心一言研究投入的服务器折旧费用和云相关费用增加。2023 年第三季度,研发费用为 61 亿元,同比增加 6%,同样是因为支持文心一言研究投入的服务器折旧开支及服务器托管费用增加。

所以,大模型的研发与运维资金都是以亿做单位的。

那么,既然成本这么高,为什么又有那么多的公司要开源呢?

为什么愿意开源?

各大厂商选择开源大模型的核心动机可归结为技术迭代、商业生态构建与行业竞争的多重博弈。

1. 技术进化的加速器:社区协作与快速迭代

开源模式通过开放代码和模型权重,吸引全球开发者共同参与优化,形成众人拾柴火焰高的生态优势。

例如,腾讯混元开源视频生成模型时,其技术负责人明确表示,当前视频生成领域的开源生态不完善,许多高质量模型因闭源而无法广泛应用。

通过开源,开发者可直接基于现有模型进行二次开发,无需重复投入高成本的训练资源,显著加快行业创新步伐。

此外,开源模型的透明性允许社区对模型进行全面审查,及时发现并修复漏洞,例如 Hugging Face 的红队计划通过众包机制提升模型安全性。

简单理解就是:开放模型代码和参数,让全球开发者一起优化,避免重复造轮子。同时利用全球开发者的智慧扩展模型的性能以及发现模型的漏洞。

2. 商业生态额扩张:从工具到云服务的全链路绑定

开源大模型往往与厂商的基础设施和工具链深度绑定,形成 “开源模型 + 商业化服务” 的闭环。

可以通过开源模型,让有意向的用户尝试和了解模型是否满足需求,当意向用户进行更深入的使用时,会发现直接使用模型原厂商提供的云服务更有性价比。从而引导用户进入到后续的云服务消费。

- 谷歌 Gemma:与 NVIDIA 合作优化模型在 GPU 上的性能,并通过 Google Cloud 的 Vertex AI 提供一键式部署服务,吸引企业用户使用其云资源。

- 微软 PIKE-RAG:针对企业私有数据场景开源知识增强框架,同步推出 Azure 云平台的定制化微调服务,推动企业客户从开源模型转向付费的 MLOps 工具链。

- Meta Llama 3.1:通过开源高性能模型,联合 AWS、Databricks 等云服务商提供全栈支持,降低企业部署门槛,同时强调 “开发者可在自有基础设施上运行,成本仅为闭源模型的 50%”,直接冲击 OpenAI 等闭源厂商的市场份额。

3. 行业标准的争夺:开源即话语权

不知道大家是否听说过三流企业卖产品,二流企业卖服务,一流企业卖标准。

在 AI 领域,技术标准的制定权往往决定市场格局。

Meta 的 Llama 系列通过持续开源,已成为全球开发者使用最广泛的开源模型之一,其 405B 参数版本性能可媲美 GPT-4o,直接挑战闭源模型的技术霸权。

扎克伯格明确表示,开源 AI 将凭借开放性和可修改性,像 Linux 取代 Unix 一样成为行业主流。类似地,谷歌开源 Gemma 时,强调其与 Gemini 同架构,目标是在端侧 AI 领域建立标准,抢占手机、PC 等设备的本地推理市场。

可以理解成,最终谁占据的市场多。那么就可以主导市场蛋糕的划分。

微软的windows系统能够占据这么大的市场,除了产品的成功以外,和微软放任各大盗版系统猖獗,培养了大量windows系统用户有很大关系。

4. 应对竞争与监管:平台内卷与审核风险

OpenAI作为第一个发布商业大模型的公司,一直采取的闭源的方式。最终OpenAI也在今年宣布开源自 GPT-2 以来的首个模型,被解读为对中国公司如 DeepSeek 崛起的回应。DeepSeek 的 R2 模型在代码生成基准测试中超越 GPT-4,其开源策略吸引了大量企业客户,迫使 OpenAI 重新平衡开源与商业化。

原先国外的OpenAI,国内的文心一言。初始版本都是闭源的思路。但谁知道后面的选手们直接开源。有便宜的,谁愿意用收费的?

这个过程,很像微软和苹果,苹果系统一直闭源,软硬件捆绑式销售。

而微软直接让windows盗版横行,全面培养用户对windows系统的使用习惯。

最终的结果就是windows成为了PC时代最大的赢家。要知道苹果可是首个在商用领域使用图形用户界面的操作系统,我们常见的桌面,窗口,图标等都是来源于苹果。

现在各大厂商明显是有吸取苹果的教训。

关于审核风险,主要就是各大政府对大模型的信息合格的审核了。

欧盟《人工智能法案》和中国《生成式人工智能服务管理暂行办法》要求模型具备可解释性,开源旧模型通过公开架构和权重,更容易通过合规审查。

例如,阿里云通义千问的开源模型已通过中国备案,衍生模型超 10 万个,成为全球最大开源模型族群。

5. 数据与场景的反哺:从模型到应用的价值闭环

开源模型的广泛使用能为厂商带来数据反哺和场景验证。

例如,通义千问开源后,全球下载量超 2 亿次,覆盖医疗、金融等多个领域,其衍生模型为阿里积累了大量垂直场景数据,进一步优化基础模型

这种实际案例不仅验证了模型价值,还为厂商提供了商业化落地的参考模板

6. 成本与效率的平衡:最终还得落实到成本

对于企业用户,开源模型在数据隐私和部署成本上具有显著优势。

例如,企业可将开源模型私有化部署,避免敏感数据上传至第三方服务器,同时通过自主微调降低对闭源 API 的依赖。

微软在工业场景中测试 PIKE-RAG 时发现,开源模型结合企业私有数据后,问答准确率显著提升,且推理成本低于闭源方案。

结论

开源大模型的本质是技术普惠与商业可持续的动态平衡。

厂商通过开源吸引开发者、构建生态、争夺标准,同时通过云服务、定制化支持等增值服务实现盈利。

随着端侧智能需求的崛起和行业分工的细化,开源模式正从边缘走向主流,其最终价值不仅在于模型本身,更在于能否通过社区协作和生态整合,推动 AI 技术真正融入千行百业。

正如扎克伯格所言:开源 AI 代表了利用技术为所有人创造最大经济机会的最佳路径。

风险低,收益高。同时还可以给后来者设立超高的门槛。最后还站在了道德高地。

为什么不开源卷卷呢?对吧。

而且,各大厂商,并不是将最新的模型进行了开源,性能最好最强大的现在都还是商业收费版。

开源的都是弱了几个版本的。 如果有人能够在弱化的版本上还能追上最新的商业版本,他们就可以吸取经验来进步了。这也是一个阳谋了。

文章来自于微信公众号“Zinyan”。