五年前,GPT-3 首次展示了通过自回归语言模型+大规模无标注数据训练,可获得强大 In-Context Learning(ICL)能力,并能通过少样本迁移到新任务,从而使语言开启通用人工智能(AGI)新纪元。然而在语音领域,现有模型仍严重依赖大规模标注数据,难以快速适应新任务达到类人智能。

这一瓶颈如今被打破。小米正式开源首个原生端到端语音模型——Xiaomi-MiMo-Audio,它基于创新预训练架构和上亿小时训练数据,首次在语音领域实现基于 ICL 的少样本泛化,并在预训练观察到明显的“涌现”行为。

后训练进一步激发了 Xiaomi-MiMo-Audio 的智商、情商、表现力与安全性在内的跨模态对齐能力,语音对话在自然度、情感表达和交互适配上呈现极高的拟人化水准。

不止开源,欲与闭源试比高

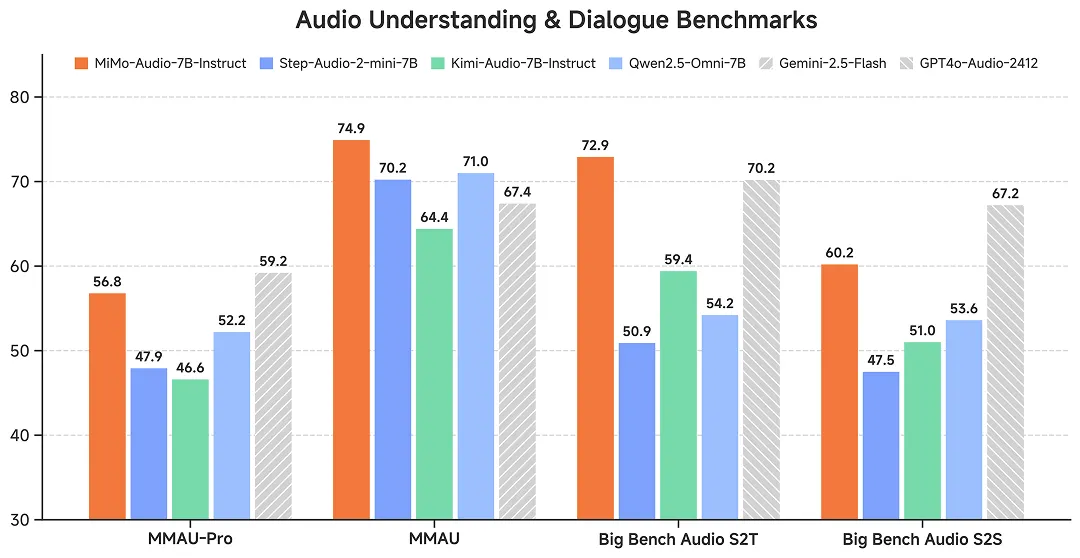

得益于创新模型结构 + 上亿小时数据预训练 + 轻量后训练,Xiaomi-MiMo-Audio 性能亮眼,具体如下:

- 在通用语音理解及对话等多项标准评测基准中,MiMo-Audio 大幅超越了同参数量的开源模型,取得 7B 最佳性能

- 在音频理解基准 MMAU 的标准测试集上,MiMo-Audio 超过 Google 闭源语音模型 Gemini-2.5-Flash

- 在面向音频复杂推理的基准 Big Bench Audio S2T 任务中,MiMo-Audio 同样超越了 OpenAI 闭源的语音模型 GPT-4o-Audio-Preview

多重创新,多个首次

Xiaomi-MiMo-Audio 主要贡献如下:

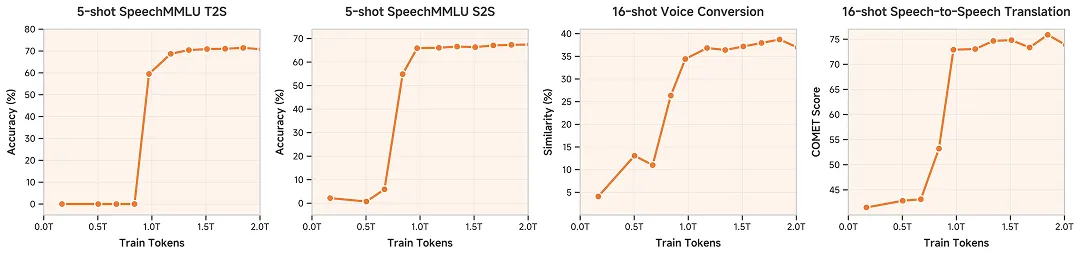

- 首次证明把语音无损压缩预训练 Scaling 至 1 亿小时可以“涌现”出跨任务的泛化性,表现为 Few-Shot Learning 能力,见证语音领域的 “GPT-3 时刻”

- 首个明确语音生成式预训练的目标和定义,并开源一套完整的语音预训练方案,包括无损压缩的 Tokenizer、全新模型结构、训练方法和评测体系,开启语音领域的“LLaMA 时刻”

- 首个把 Thinking 同时引入语音理解和语音生成过程中的开源模型,支持混合思考

技术、模型、评估均开源

我们采取简单、彻底和直接的开源风格,希望促进语音研究领域加速向前:

模型

- 预训练模型 MiMo-Audio-7B-Base:是目前开源领域第一个有语音续写能力的语音模型

https://huggingface.co/XiaomiMiMo/MiMo-Audio-7B-Base

- 指令微调模型 MiMo-Audio-7B-Instruct:经过轻量级的 SFT,7B 参数规模最强语音理解和生成模型

https://huggingface.co/XiaomiMiMo/MiMo-Audio-7B-Instruct

MiMo-Audio-7B-Instruct 可通过 prompt 切换 non-thinking、thinking 两种模式,强化学习(RL)起点高、潜力足,可以作为研究语音 RL 和 Agentic 训练的全新基座模型。

Tokenizer

我们开源了 MiMo-Audio 的 Tokenizer 模型:

- 1.2B 参数量,Transformer 架构,兼顾效率与性能

- 从头开始训练,覆盖超过千万小时语音数据

- 同时支持音频重建任务和音频转文本(A2T)任务

Tokenizer 高效实现的推理代码如下:

https://github.com/XiaomiMiMo/MiMo-Audio-Tokenizer

技术报告

MiMo-Audio 技术报告已公开,全面展示了模型和训练细节:

https://github.com/XiaomiMiMo/MiMo-Audio/blob/main/MiMo-Audio-Technical-Report.pdf

评估框架

我们提供了一套完整的语音模型预训练 ICL 测评、后训练评估框架,支持 10+ 测评任务,已开源至 GitHub。

https://github.com/XiaomiMiMo/MiMo-Audio-Eval

完整实例展示

访问 https://xiaomimimo.github.io/MiMo-Audio-Demo/ ,可查看更多 MiMo-Audio-Base 模型的语音续写、ICL 能力的实例,并解锁 Instruct 模型在 Audio Caption、Long Audio Understanding&Reasoning 和 Instruct TTS 等方面的能力。

下一步

我们认为,MiMo-Audio 的开源将显著加速语音大模型研究对齐到语言大模型,为语音 AGI 的发展提供重要基础。

我们会持续开源,期待与每一位同行者携手,用开放与协作,迈向语音 AI 的“奇点”,走进未来的人机交互时代。

文章来自微信公众号 “ Xiaomi MiMo “