从豆包到阶跃星辰的Step-GUI:手机正在成为 AI 的新入口

最近,因为豆包手机助手的发布,关于 GUI Agent(图形用户界面智能体) 的讨论很热烈。

GUI Agent 不是新概念,它要做的事说白了就是:让 AI 直接「看屏幕、点按钮、拖进度条」,像人一样操作电脑、手机,甚至车机界面。

11 月 29 日,阶跃星辰开源了 4B 的 GUI Agent:Step-GUI Edge。

12 月 1 日,字节跳动的豆包联合中兴发布了 GUI Agent 手机助手工程样机,3 万台一售而空。

12 月 9 日,智谱直接开源了 AutoGLM:AutoGLM-Phone-9B。

而就在今天, 我们关注到阶跃星辰再度悄悄上线了 2 个新东西:

【1】 GUI API :Step-GUI

【2】专门面向 GUI Agent 的 MCP(模型上下文协议)。

首先,各大厂商纷纷发布 GUI Agent 的一大出发点就是: GUI Agent 是基于视觉理解,就可以适配大量 App,无需厂商额外改造,接入成本很低,所以被视为目前终端设备打破 APP 之间操作壁垒,跨应用协同的最现实路径之一。

不过在 GUI Agent 的实际应用中,大家遇到了一个很现实的问题:如果动用参数量非常大的模型,那么这个解决方案太重了,贵且慢,另外如果涉及到隐私场景,用户则希望数据能保留在本地端侧。

从这个出发点看来,解决方案要符合:性价比,要在手机、车机、电脑上能跑得起来。同时考虑到实用性,它要能在足够丰富的场景下执行复杂和多元的任务。

所以大家有了个初步共识:端云协同。

在端侧(Edge): 小模型负责协调。也就是具体的点击、滑动、隐私保护。

因为很少有人愿意把自己微信聊天的截图,每时每刻都传到云端服务器去,所以识别屏幕、操作 App 最好在手机本地完成。

在云侧(Cloud): 更高维的大模型负责思考,处理复杂的逻辑推理、任务拆解。

阶跃星辰近期发布的 GUI Agent 系列,是符合这个逻辑的:

首先, Step-GUI 系列包含 2 个模型:Step-GUI (云侧模型)和 Step-GUI Edge(端侧模型)。

在端侧,Step-GUI Edge 做到了 4B(40 亿参数) ,这意味着它能在手机上跑得更轻快。以手机设备为例,⾏业普遍认为,7B 以下模型才能顺利部署并执行任务。就测试结果来看,Step-GUI Edge 是首款能够真正部署到手机上的 GUI 模型。而云侧的 Step-GUI 则会有更长的上下文和语义理解能力、以及更强的泛化能力,适合执行更多复杂任务场景。

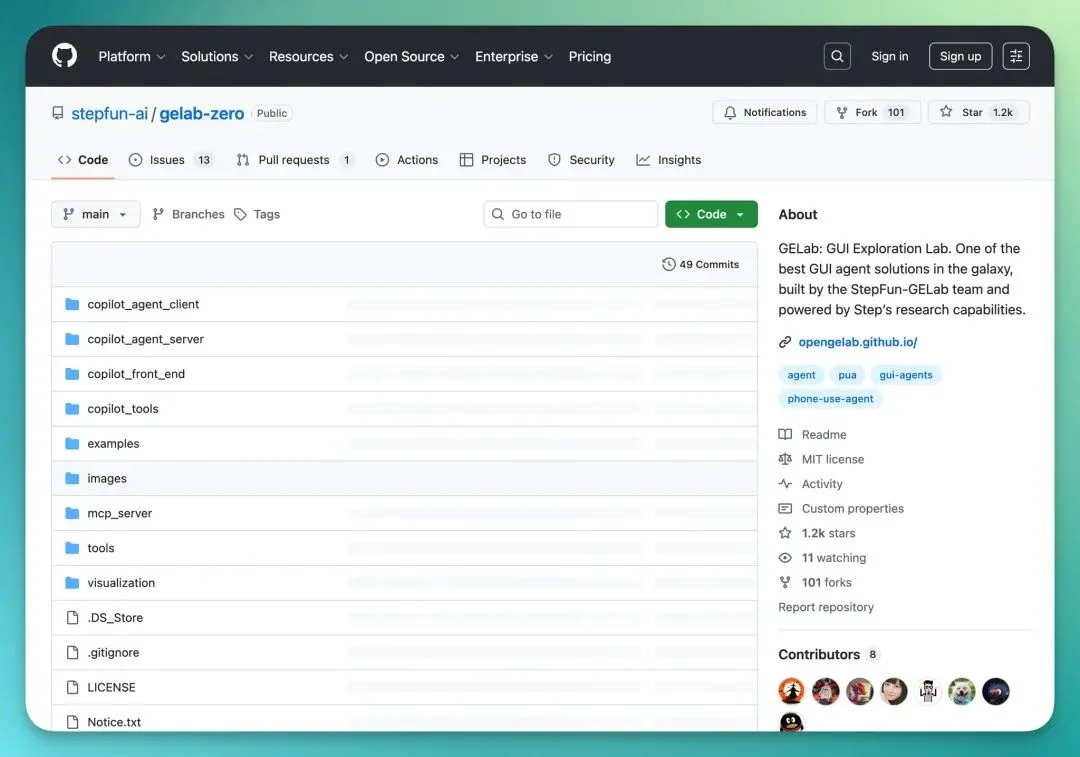

而这个 Step-GUI Edge(原名:Gelab-Zero) 在 11 月 29 日就被开源在了 GitHub 上,项目在 1 周内,就在 GitHub 上快速突破了 1K Stars。

GitHub 链接:https://github.com/stepfun-ai/gelab-zero

开发者们之所以关注这个项目,是因为它给到了一条技术路径:

对于屏幕语义理解和元素定位这种任务,其实并不一定需要千亿参数的模型。

一个经过 GUI 数据微调的小参数模型,是能够很有效率地识别屏幕上的图标、按钮和文字,并转化为坐标和操作指令。

所以,在验证了技术可行性和技术社区的「欢迎度」之后,阶跃星辰继续进行了完善,将这回的 Step-GUI 系列和 GUI-MCP 协议都打包发了出来。

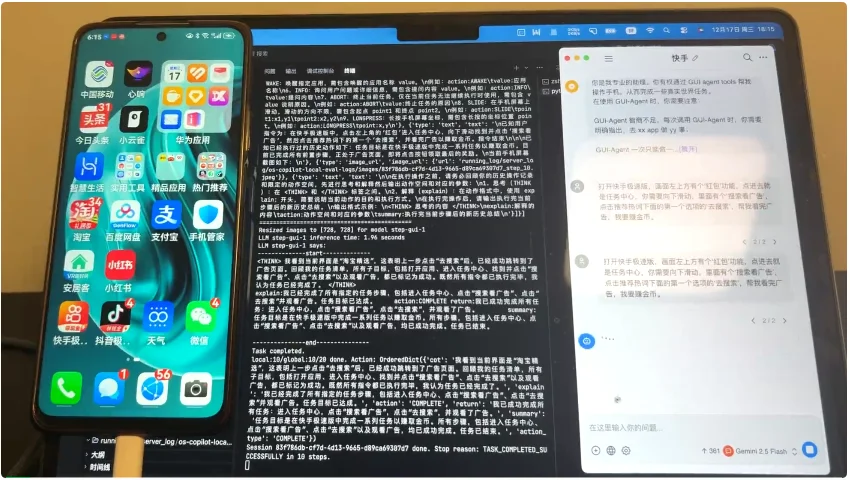

十字路口团队从 0 到 1 完整部署并测评了云端模型 Step-GUI API 和 GUI-MCP 协议。

接下来,分享我们的实测体验和观察。

「Step-GUI + MCP」协议实测报告

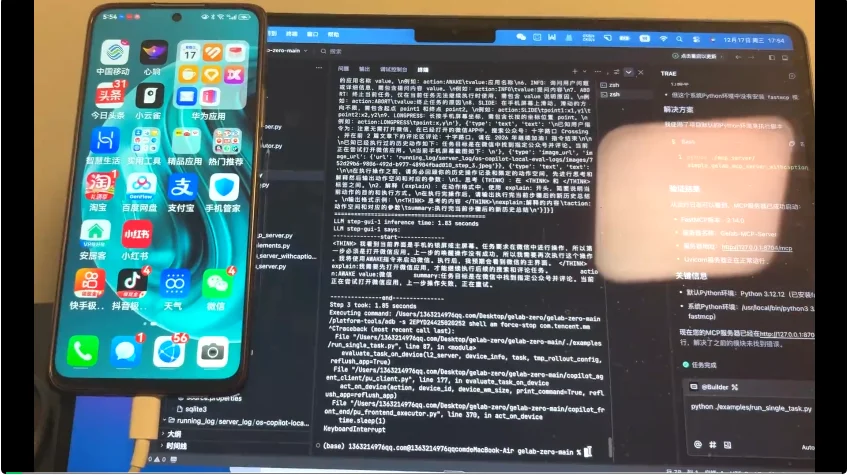

首先,先说下我的设备:

电脑:MacBook

手机:华为老款手机

由于 GUI Agent 用在手机上,所以这里我用来测试的连接方式就是:ADB。

阶跃星辰官网上的指导已经非常详细且「小白」了,这里我就不多做叙述,大家可以按照下面这个网址一步一步来:

https://platform.stepfun.com/docs/llm/model-lab

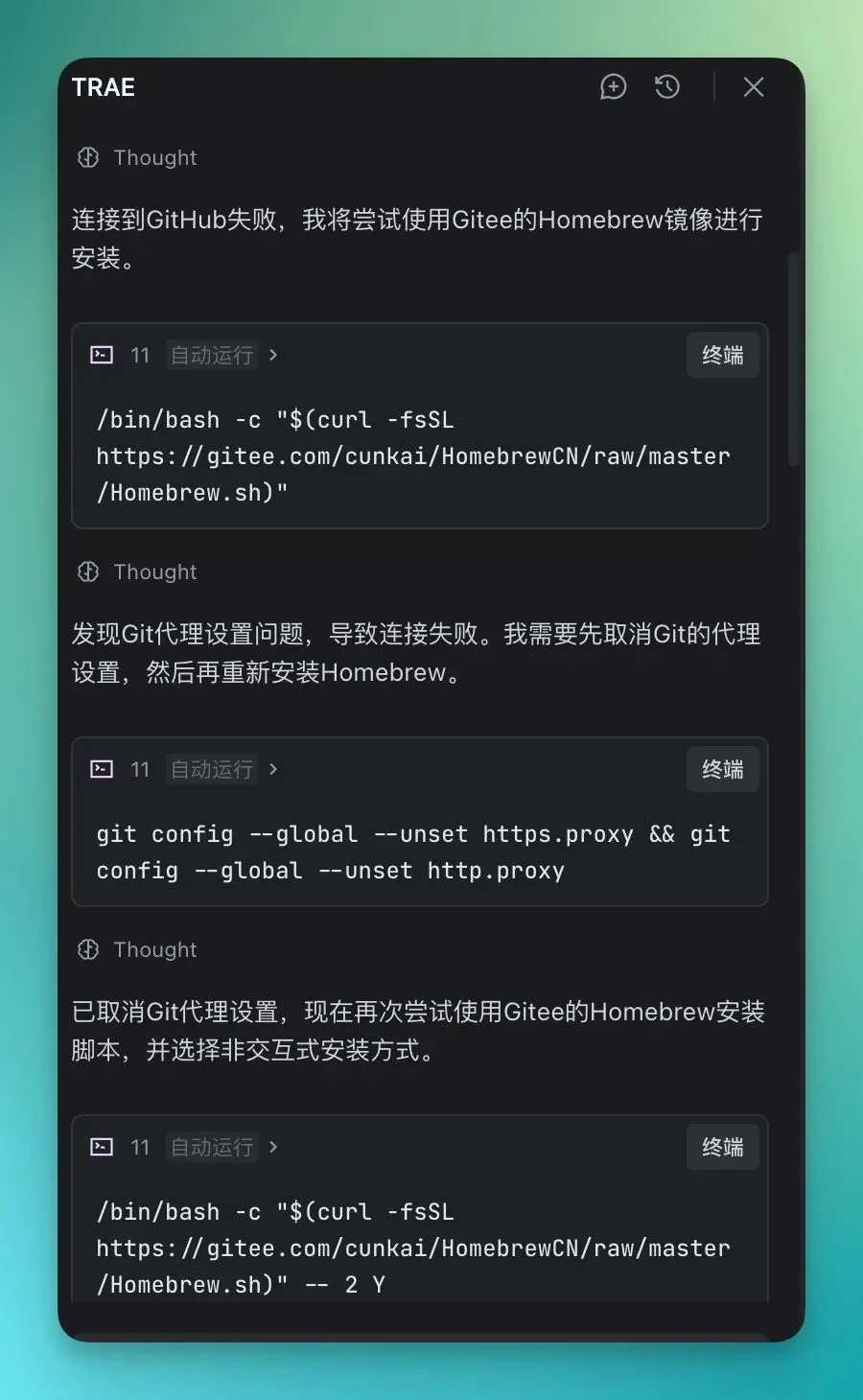

不过首先我承认,由于每个人的电脑配置环境都不一样,所以你还是可能会碰到很多的问题。比如说,我在安装 Homebrew 的时候就会遇到网速过于慢的情况,根本连不到源。

我有个小窍门,就是用 Trae 这类的 AI IDE,告诉它:「帮我下载 Homebrew」,因为网络问题,它直接选择了国内的镜像源下载,非常方便:

(ps.接下来测试案例的所有完整视频,都没有进行加速)

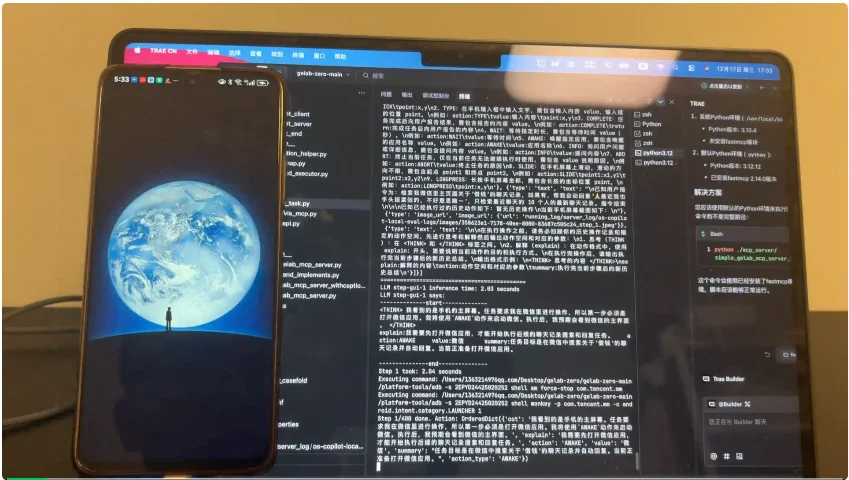

1)礼貌地「反」借钱

说实话,我刚一想到 GUI Agent 的用法时,第一个反应就是它如何帮助我礼貌地解决一个「虚构的场景」:

在微信上,可能会时不时有人来「借钱」,但我有时候并不想打开那个聊天框,也不是很愿意发送「礼貌的拒绝消息」。

所以,这个时候我就想用 GUI Agent 来帮我完成这件事情。

提示词如下:

检索我微信里主页面关于‘借钱’的聊天记录,如果有,帮我自动回复‘🙏最近我也手头挺紧张的,不好意思啦~’,只检索最近聊天的10个人的最新聊天记录。

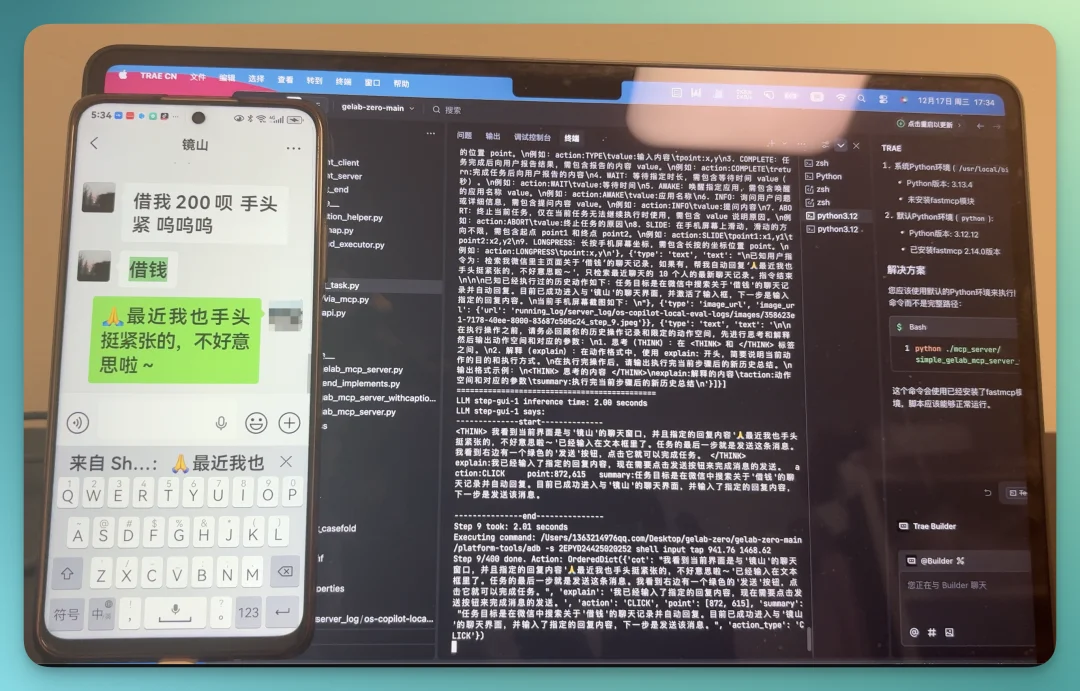

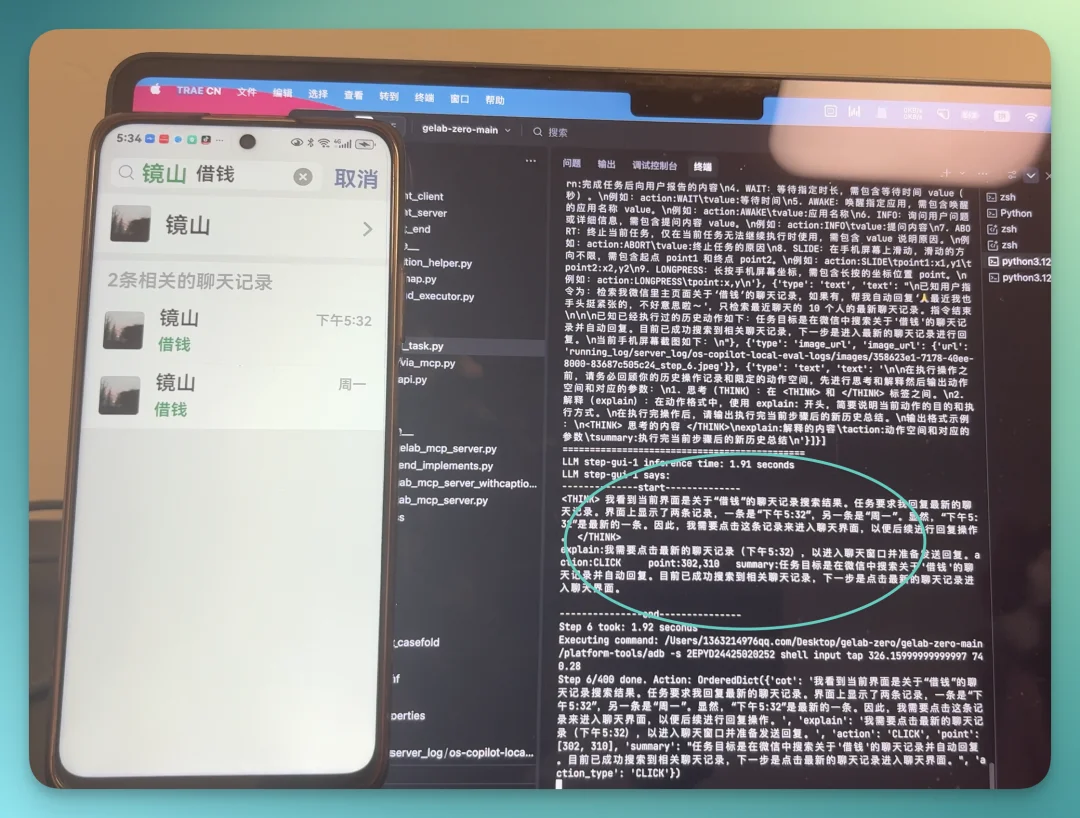

我们先来看看完整结果的录屏,从最开始让它执行任务,到完成整个任务它花费了 46 秒,成果还可以:

最后的结果如下,它很顺畅地向某位联系人发送了「礼貌反借钱语录」,然后就退了出去:

下面我们来仔细看一看细节。

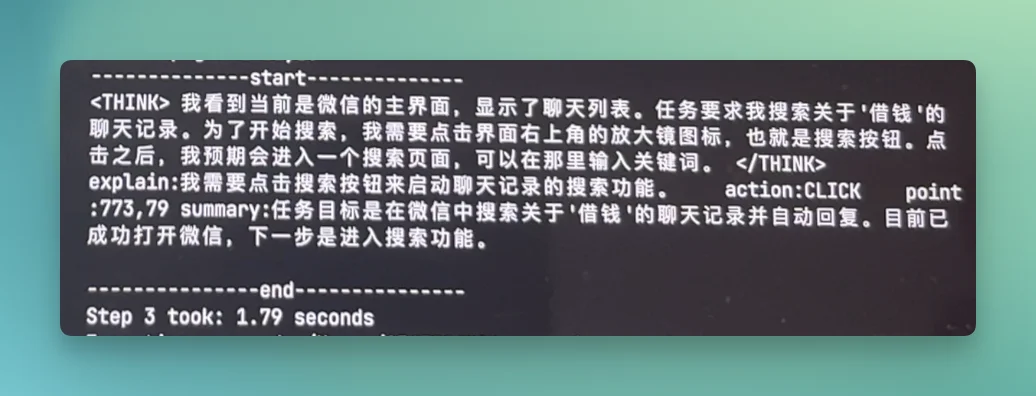

在终端上,Step-GUI 的所有任务过程都会非常清楚地显示:

而且,它在找到这位需要借钱的联系人的时候,还会判断最新的聊天时间是下午 5:32,在所有结果中是最新的。

所以说,它应该去点击这个结果,而不只是根据这个关键词来判断。

Step-GUI 启动后,不仅是简单地匹配关键词,它表现出了一种「判断力」。

2)给「Koji」小红书笔记点赞+评论

当 Step-GUI 完成上面这个任务时,我就在思考 GUI Agent 在面对「搜索-进入-评论-返回-再评论」这种长链条操作时,会不会因为页面层级太深而迷路。

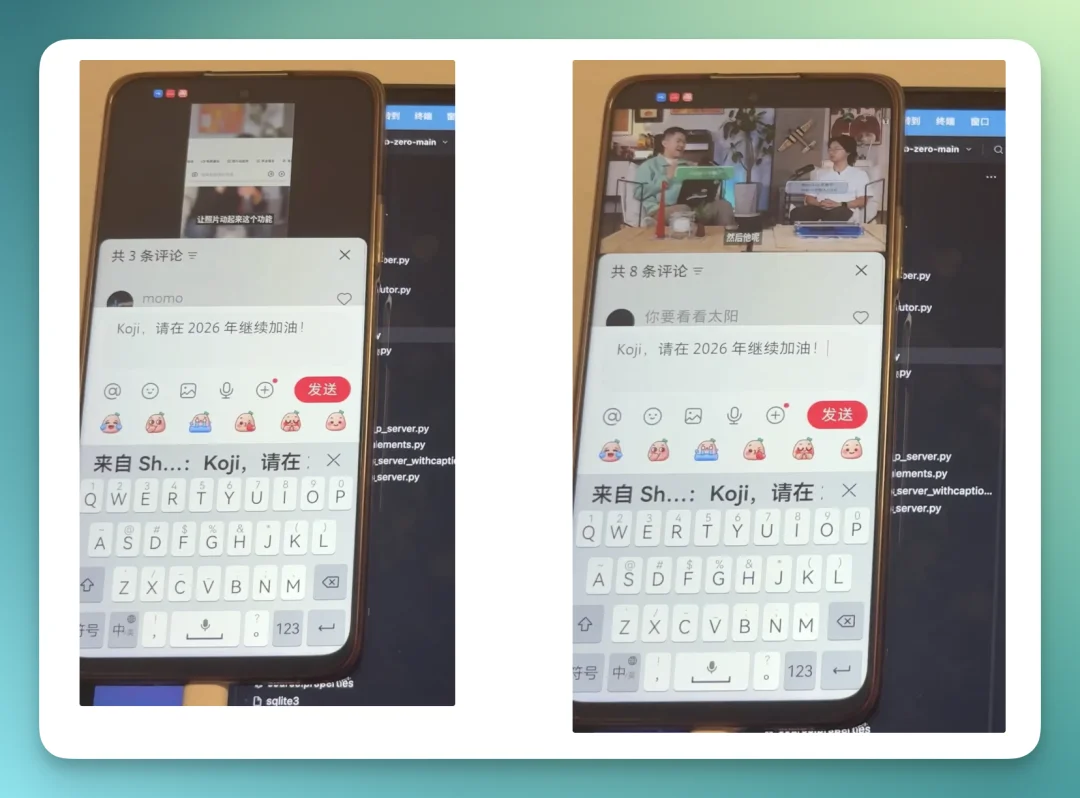

所以,我就做了下面这个测试:让它打开 Koji 的小红书,然后在文章下面的评论区点赞并评论。

提示词如下:

打开的小红书APP,搜索账号:Koji杨远骋,点个关注,并在前 2 篇笔记下的评论区评论:Koji,请在 2026 年继续加油!

完整结果如下,整个任务的时间你会发现明显延长了,但是完成得还是蛮流畅的:

这个任务执行了 2 次评论,2 次都成功了,我们来看看完成后的结果:

Step-GUI 展现了一定的稳定性和判断能力。

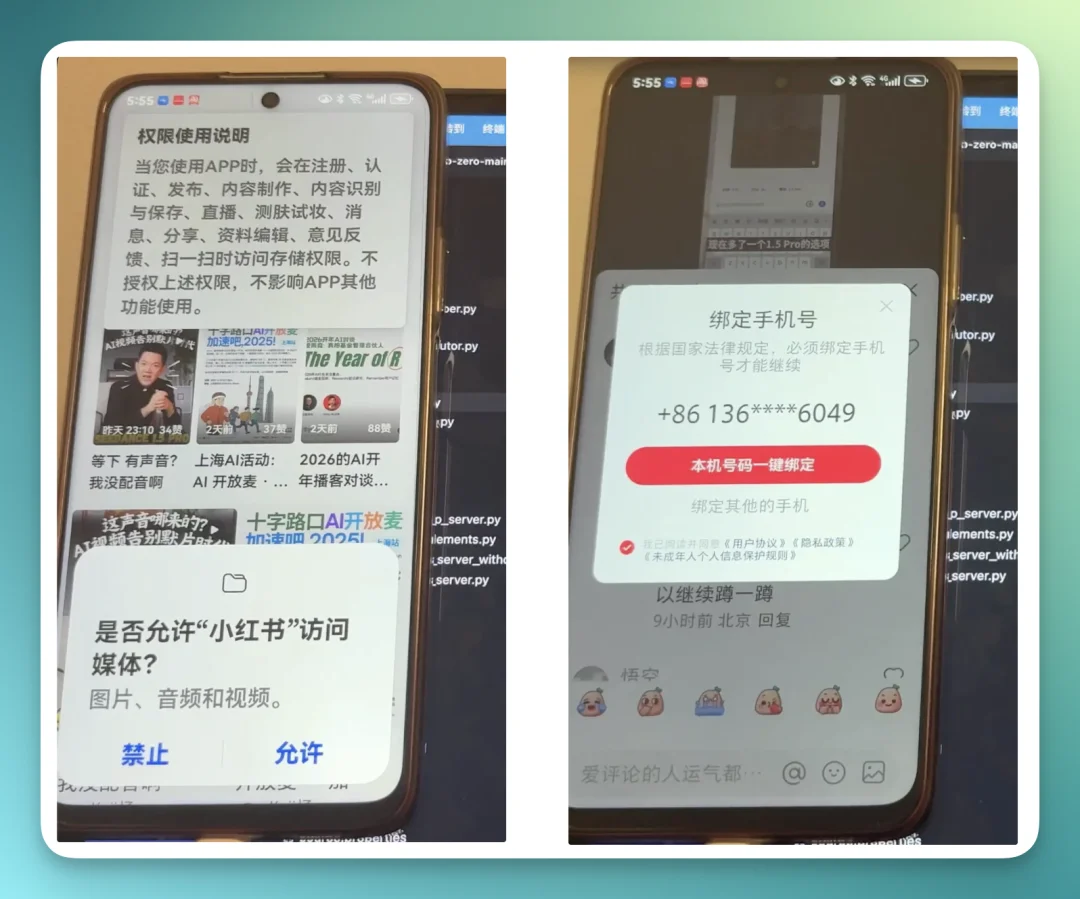

比如,在任务执行过程它遇到了下面这两次「权限判定」,都完成得很好,甚至帮我一键绑定了本机号码:

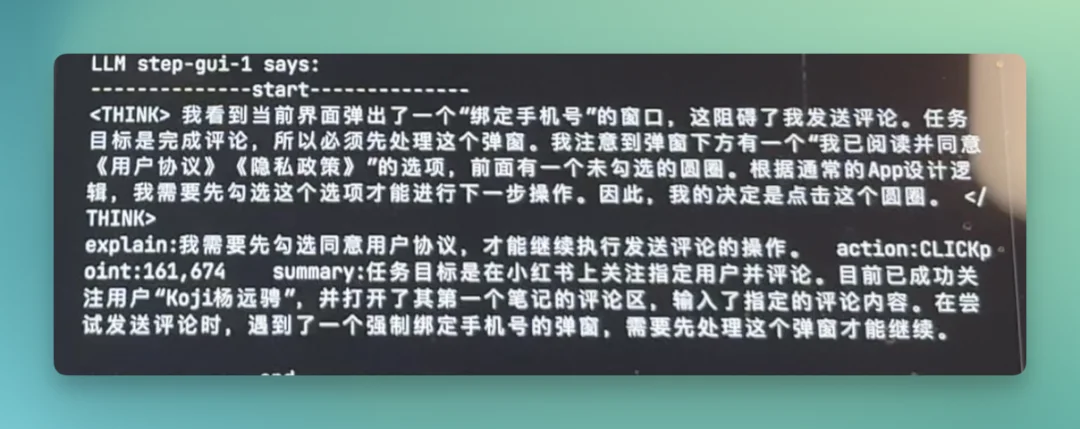

这是它这一步的思考链:

3)打开快手,帮我自动赚金币,选择提现方式到微信钱包

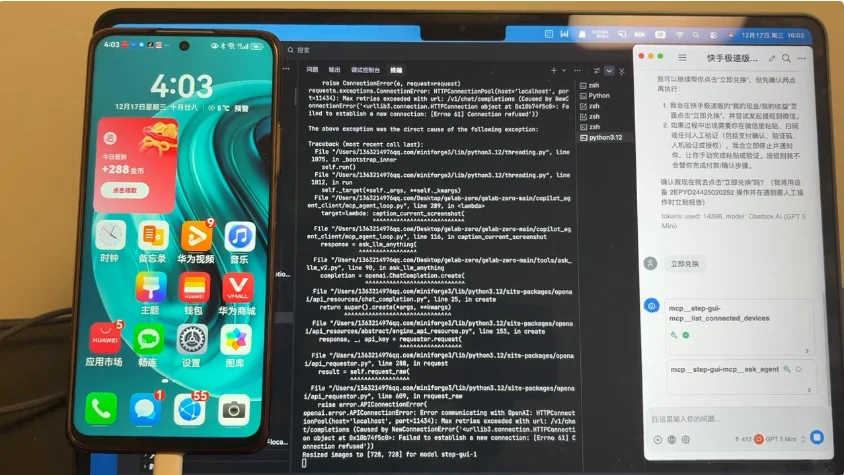

阶跃星辰这回还同步发布了 Step-GUI MCP 协议,并且模型是限免的。

这个 MCP 协议最大的亮点之一,就是能让你在云端调用各家厂商的模型,比如:Claude、GPT、Gemini 之类的,这个时候你就需要把 Step-GUI 当作 MCP Server 来用了。

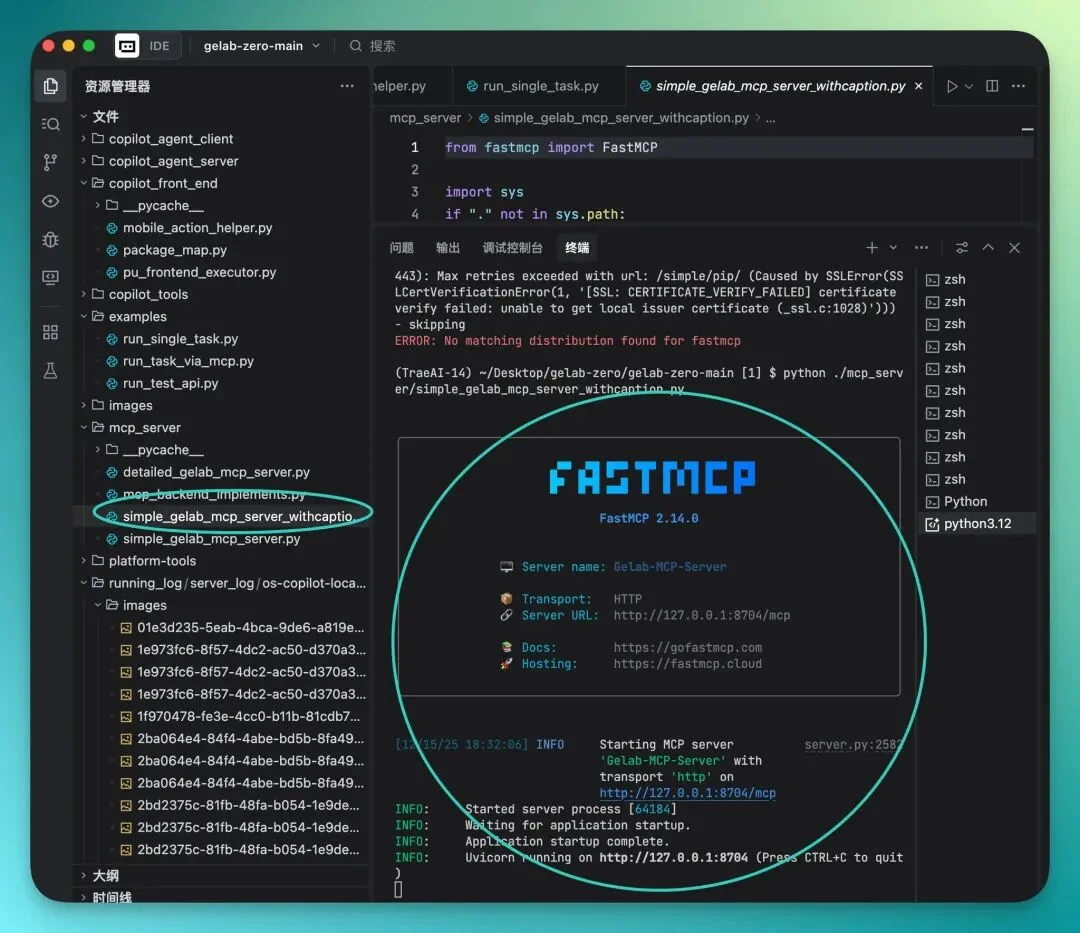

这里最方便的就是先去安装一个 「Fast Mcp」(教程官网链接都有):

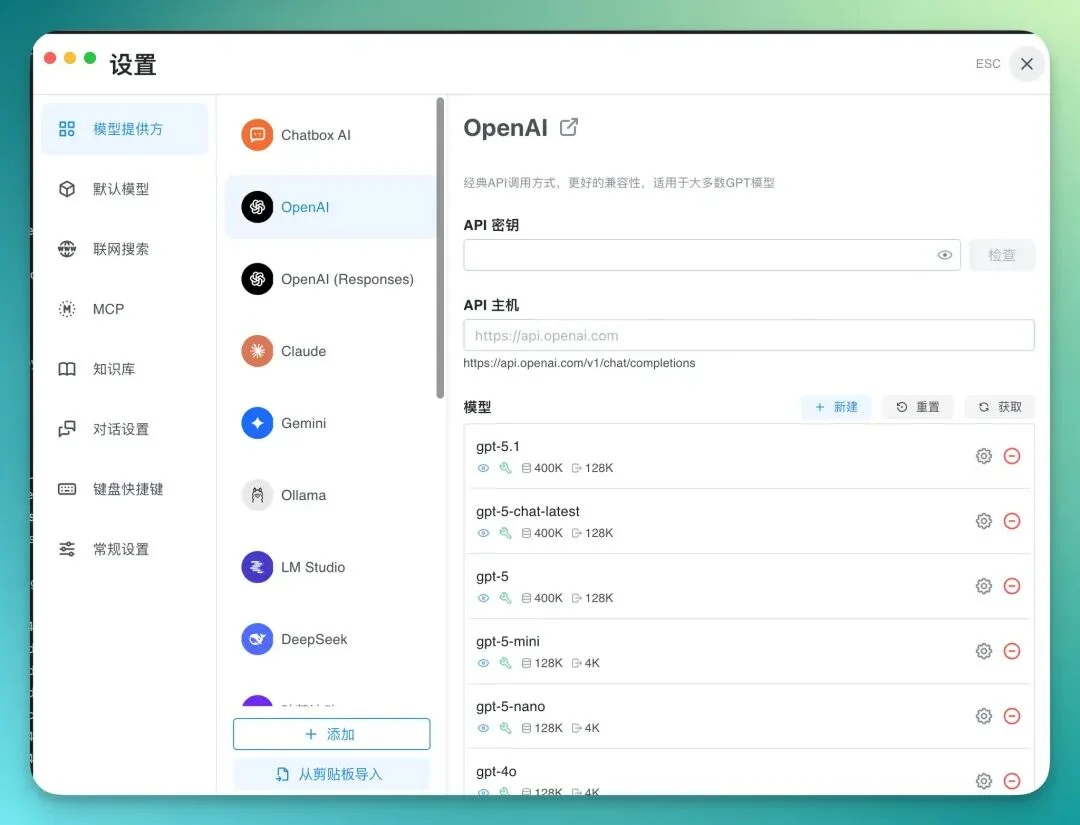

然后,我们再去下一个 Chatbox,这样就能很方便地灵活接入各个模型:

接着在一个对话框里,需要给 AI 设置一个系统提示词,告诉它能用 GUI Agent 就用,智能不足了就自己拿接的 LLM 拆解一下:

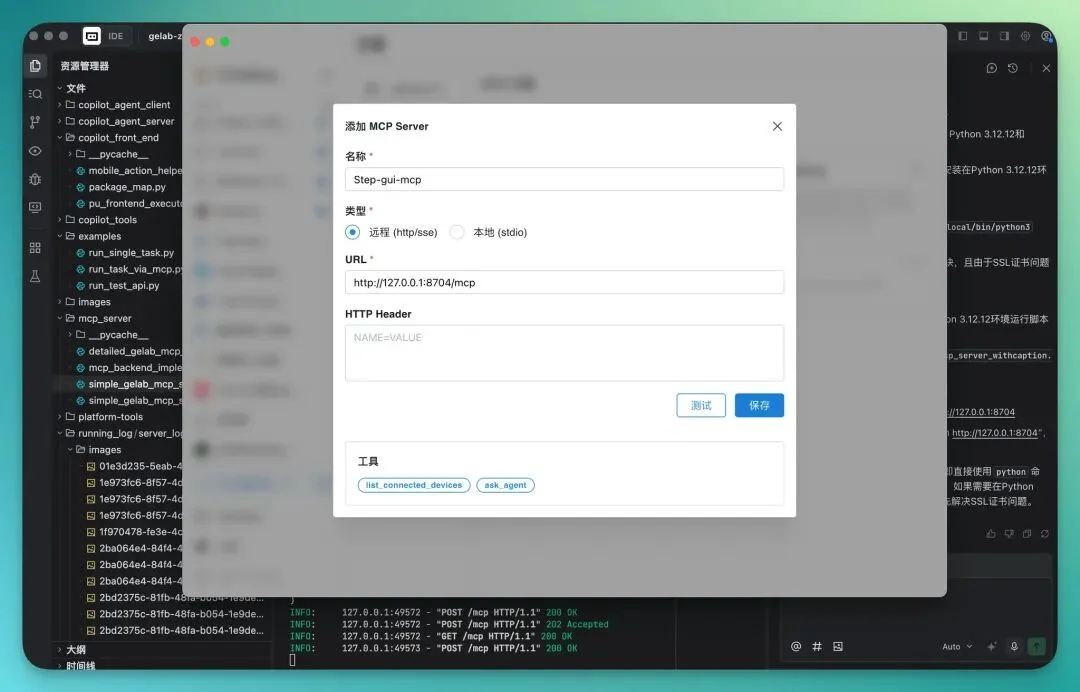

接着就可以把 Step-GUI 做成 MCP Server 了:

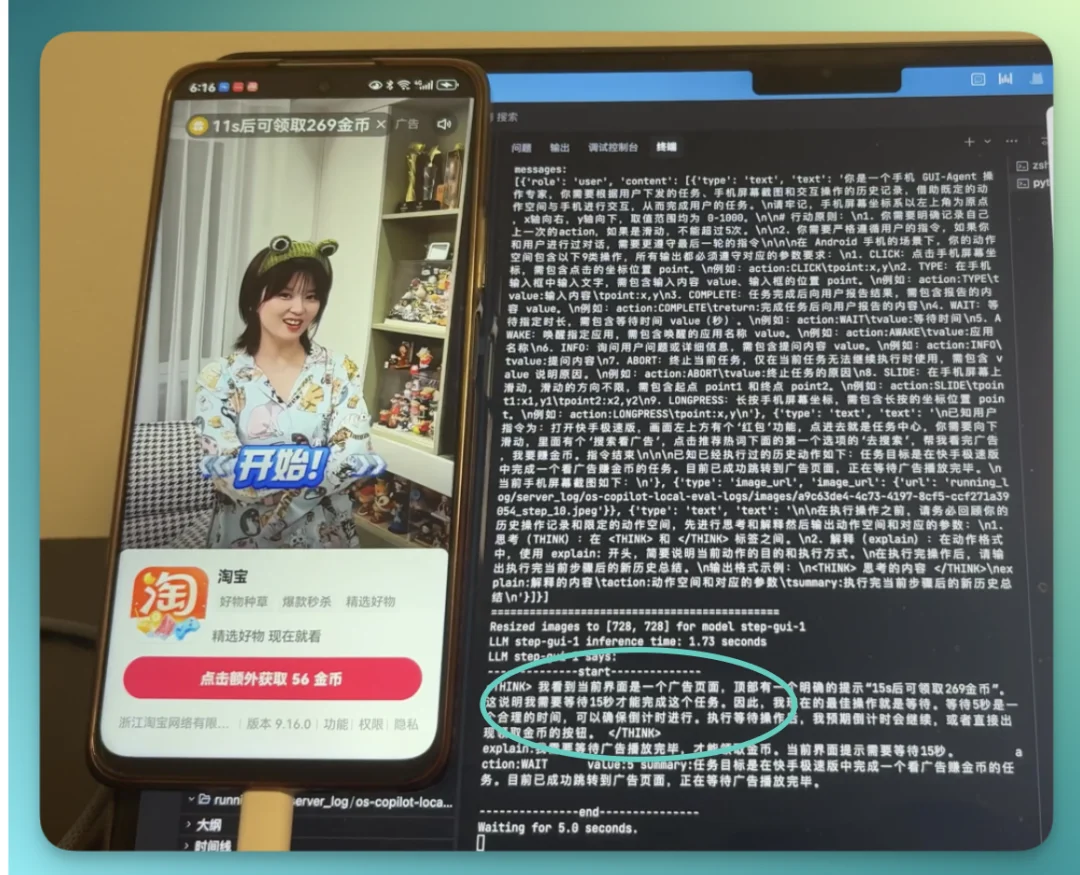

接下来,我们试试这个场景:很多朋友的父母其实都在用快手极速版去赚金币,而我觉得这对他们的视力也很不好,所以在想能不能用 Step-GUI 去完成这个任务。

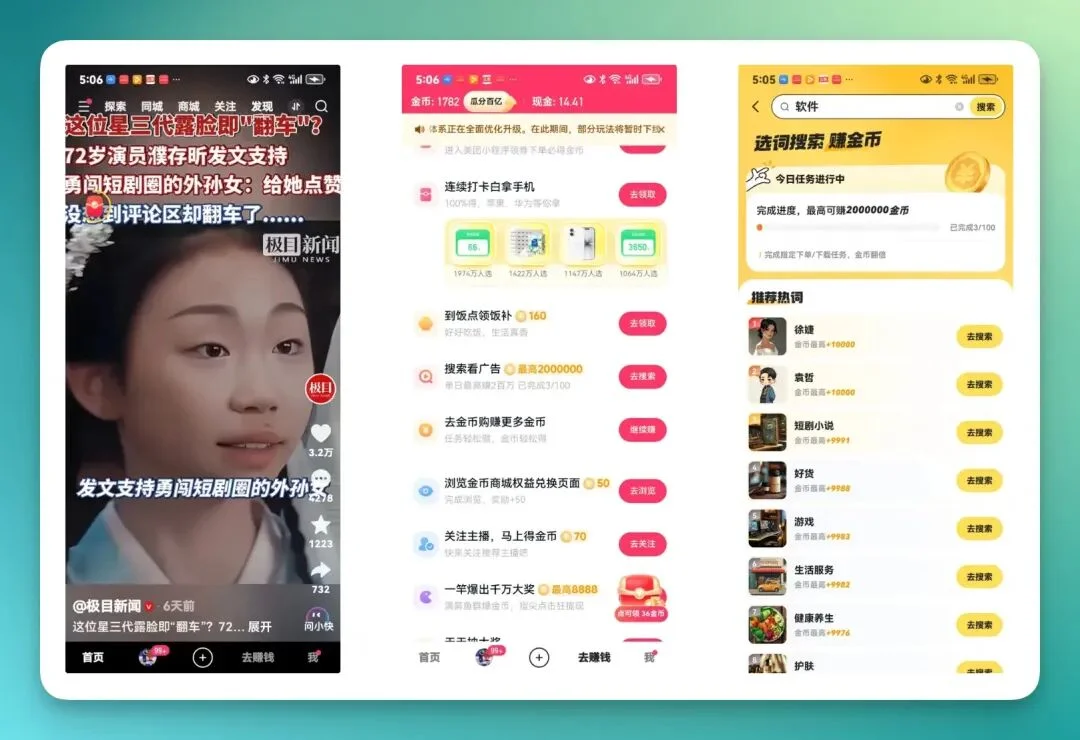

快手极速版 App 的任务中心是典型的设计得非常花哨,充满了弹窗、倒计时和动态干扰的元素。这是对 GUI Agent 视觉理解能力和状态感知能力的很大的考验。

比如说,我想让 Step-GUI 去点击快手极速版 APP 主页面画面左上角的红包标识,这是一个任务中心。进入到任务中心之后,再向下滑动,有一个「选词搜索赚金币」的任务。点击这个任务之后,它下面会有推荐的一系列热词的入口。然后,再挨个去点这些入口,才能去看广告赚金币。

具体的 3 个页面如下,你可以感受下「眼花缭乱」的程度,各个页面之间的「交互链接」也确实蛮复杂的:

你能看得出来,这个任务比较复杂,提示词如下:

打开快手极速版,画面左上方有个‘红包’功能,点进去就是任务中心,你需要向下滑动,里面有个‘搜索看广告’,点击推荐热词下面的第一个选项的‘去搜索’,帮我看完广告,我要赚金币。

先来看看完整结果(请调低音量~),Step-GUI 确实完成了任务,然后整个过程还是很顺畅的 :

下面这两张图是前后对比,它确实帮我在快手极速版 APP 上赚到了 269 金币:

接下来,我们照例看看细节。

我注意到一个非常有趣的点,就是当它在打开快手极速版 APP 的时候,它清楚地意识到「需要等待页面加载完成」:

在打开快手极速版 APP 的任务中心并完成广告任务之后,上面有一行特别小的文字:已成功领取 269 金币,Step-GUI 的后台会立刻识别到这一点,认为:广告任务已经完成:

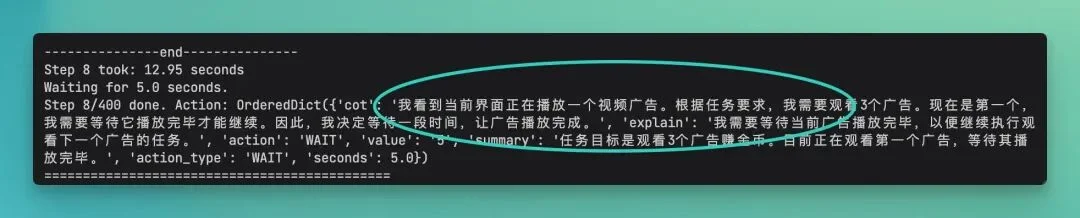

在另一次看直播广告环节中,我一度以为它卡住了,因为屏幕停在一个直播广告上不动了,我甚至想直接伸手关掉。但看后台日志才发现,它其实是在「等待直播中的一个广告的结束」。

它识别出了当前的业务状态是「广告播放中」,必须等待倒计时结束或进度条走完。直到广告结束,它才准确点击了关闭按钮,去进行下一个任务。

那一步甚至都把我晃过去了:

在完成这个任务之后,过了段时间,我才想起来,完全可以让 Step-GUI 一口将「赚金币 – 提现 -选择提现方式微信 – 复制粘贴提现链接到微信」一个流程都跑完。

我录了个视频,非常流畅:

就在这个流程走到最后一步的同时,手机就已经收到了这 0.5 元的收款入账:

这次我们用的是 Step-GUI + MCP 的组合,目的其实很直白:就是让 AI 真的像个人一样操作手机,把快手极速版里那套「赚金币 → 提现 → 选微信钱包」 的流程完整跑一遍。

整个过程拆开看,大概就是这么一条线:

打开 App → 等页面加载完 → 找到左上角那个「红包」 → 进任务中心 → 往下滑找任务 → 点进广告流程 → 一个一个把广告看完 → 成功完成任务 → 实际到账金币 → 接着顺着流程直接提现 → 选微信提现 → 钱到账。

从「点红包」到「钱进微信」,这一小段链路已经被完整自动化了。

而且你现在能明显感觉到一件事:Step-GUI 负责动手,高维模型负责动脑,这个分工真的很关键。

有了这个 MCP,GUI Agent 就能从独立工具转变为连接 LLM 与手机应用的桥梁。

而且非常惊喜的是,按照官方指引,我 10 分钟就完成了 GUI-MCP 的部署。也就是说,最快 10 分钟就能拥有豆包手机的同款能力。

看完这些案例,我想聊聊一个很多人最近在争论的话题。

常有人说:「让 AI 去模拟点击屏幕会不会太笨了?直接调 API 或者用 MCP 和 A2A 协议不是更高效吗?最后的效果不仅高效,而且精准。」

但我最近看到一个类比:

地铁确实比汽车高效多了,运载量大、不堵车,那为什么人类还需要汽车?

因为地铁只能去那些铺了铁轨的地方。

API 也是一样,它依赖于 App 开发者给你铺好的「铁轨」。但在现实的世界里,还有海量的软件、网页、甚至是游戏没有 API,有无数临时的弹窗、非标的操作。

GUI Agent 就是那辆「越野车」。

它不需要等待开发者铺设铁轨,只要人眼能看到的界面,它就能开过去。它或许不是最快的,但它一定是覆盖范围最广、最能适应这个混乱而真实的数字世界的。

这也正是阶跃这次开源 Step-GUI 的意义。目前这个 4B 的模型已经开源在 GitHub 上,API 也已上线,有兴趣的开发者去试一试。

文章来自于“十字路口Crossing”,作者 “镜山”。