对于国产 GPU 行业来说,没有哪个时间节点比当下更宝贵。在政策支持硬科技企业上市的背景下,国产 GPU 迎来了难得的上市黄金窗口期。但上市并非终点,在敲钟的那一刻,下一战场大幕已经拉开——GPU 厂商的技术路线、产品能力和长期判断,被放到了更公开也更严苛的舞台上,谁能撑起资本市场和大众期待,谁就能撑起市值。

这也是为什么,天数智芯上市后的首场发布会能够在业内形成广泛讨论。它以极其务实的工程师表达方式,把架构放回到国产 GPU 技术叙事的中心。在 1 月 26 日召开的天数智芯“智启芯程”合作伙伴大会中,围绕架构层的创新与思考占据了相当比重。基于这些创新点与思考,天数智芯公布了过去一代以及未来三代的架构路线图:

- 2025 年,天数天枢架构已经 超越英伟达 Hopper,在 DeepSeek V3 场景中实测性能数据超出 20%;

- 2026 年,天数天璇架构 对标 Blackwell,新增 ixFP4 精度支持;

- 2026 年,天数天玑架构 超越 Blackwell,覆盖全场景 AI/ 加速计算;

- 2027 年,天数天权架构 超越 Rubin,支持更多精度与创新设计。

1

国产 GPU,开启 AI++ 计算新范式

根据天数智芯公布的架构路线图及阶段发展目标,在 2027 年之前,天数智芯将通过多代产品完成对英伟达的追赶;在 2027 年之后,将转向更富创新性的架构设计,聚焦更具突破性的超级计算芯片架构设计。看似宏大,但对于仍处于爬坡阶段的国产 GPU 行业来说,这条路径实际上相当务实——只有在工程化能力上完成对标甚至是超越,国产 GPU 才有资格进入更大规模的生产环境中。

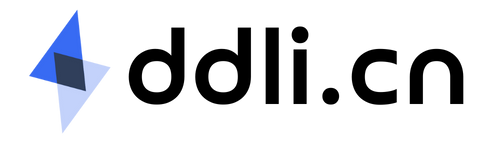

而在规模化落地阶段的竞争,焦点早已从峰值性能指标转向有效计算能力。当 Token 成为 AI 时代最基本的生产资料,当算力消耗开始对标真实业务产出,无论是国际顶尖 GPU 厂商还是国内 GPU 企业,核心命题都只有一个:如何在真实业务中,把算力转化为有效的 Token。这似乎又将大家都拉到同一起跑线。

围绕这一命题,天数智芯提出了两条明确的架构判断:其一,回归计算本质;其二,提供高质量算力。

回归计算本质,核心在于“不设限”

过去十年,规模的快速扩张带来了阶段性的产业繁荣,也使得算力实现野蛮增长。但这种粗放式发展,也带来了能效比失衡、算力资源严重浪费等问题。背后的根因十分复杂。以开车行驶为例,路途中可能会遇到雨雪冰雹天气、崎岖道路等各种复杂情况。物理、芯片、系统世界也是如此,计算、通讯、存储都会带来各种障碍。所以,幻想奔跑在平坦的赛道上毫无意义,产业真正需要的,是能够翻山越岭的全能越野车。

广义上,芯片可分为专用芯片和通用芯片:专用芯片类似“应试教育”,它的优势和边界都很清晰,能加速特定算法、特定指令,比如矩阵乘法、Softmax 这些主流任务,但一旦计算范式发生变化,适应空间就会迅速收紧;通用芯片的设计哲学,不是为了押中某一类算法,而是回归计算本质,覆盖更广泛,甚至全新的计算需求。

这也是天数智芯坚持推出并量产通用 GPU 的根因。在其看来,硬件与算法的关系本来就不应该相互掣肘,算力的僵化不应限制算法的进化,而是通过通用算力为探索未知算法提供一个坚实的底座。

支撑探索未来算法的关键,实则就是“不设限”。

基于这一判断,天数智芯的芯片设计哲学,在计算层面追求的是覆盖几乎所有的数学运算图谱,而非某一类、某一种计算:从 Scalar、Vector、Tensor 到 Cube,支持从高精度科学计算到 AI 精度计算,从 MMA 到 DPX,不管是 AI 的 Attention 机制、前沿的科学计算,还是未来的量子计算相关模拟,天数智芯全都支持。

在执行层面,追求的是更高的算力利用率:大、中、小任务会被精准分配到不同的计算单元中执行,配合高密度的多任务核心设计,算力可以被拆解、调度得更加精细,从而减少算力浪费,提高计算效率。

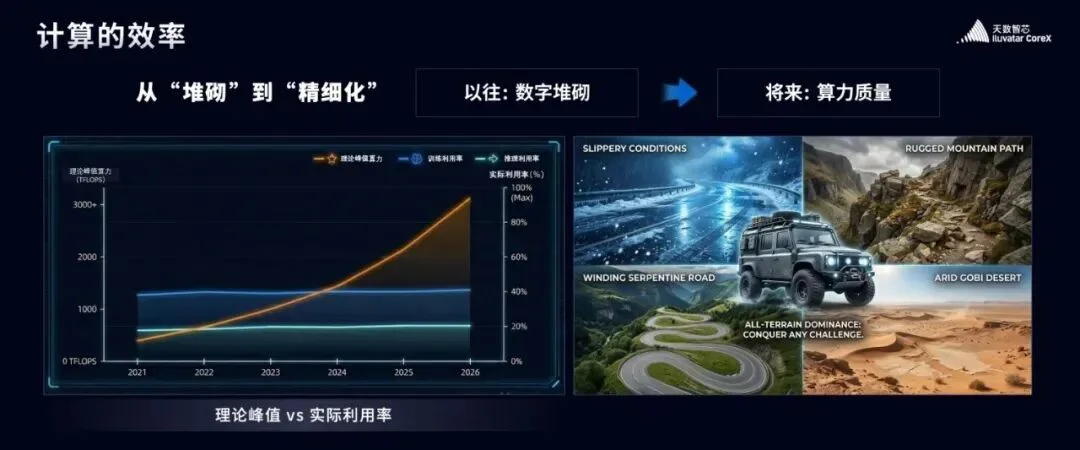

这种“不设限”的设计哲学,让天数天枢架构得以实现三大创新,这也是天枢能够超越英伟达 Hopper 架构的根因:

- TPC BroadCast(计算组广播机制)设计:不是简单粗暴地放大带宽,而是从单位带宽的使用效率入手,存在相同地址的数据时,芯片内部的 load store 单元不会进行重复、无用的访问,而是在上游进行 BroadCast,减少不必要的内存访问次数,从而有效降低访存功耗,等效提升访存带宽,用更小的功耗和面积实现相同的功能。

- Instruction Co-Exec(多指令并行处理系统)设计:在指令执行层面,通过 Instruction Co-Exec 设计实现了多种指令类型的并行执行能力,不仅支持 Tensor Core 与 Vector Core 的并行协同,还将 Exponent 计算、通信等操作一并纳入统一调度。在天数 IX-Scheduler 模块中,通过极低的成本增强了不同指令之间的并行处理能力,无论是 MLA、Engram,还是面向更复杂模型场景的计算需求,都可以在这一并行框架下被同时处理,从而提升整体执行效率。

- Dynamic Warp Scheduling(动态线程组调度系统)设计:随着 MoE 架构在大模型中被广泛采用,模型厂商普遍面临推理效率低等现实挑战。为提升并行度,微架构层面允许芯片中同时驻留更多 warp,但 warp 的增加也意味着对计算资源的竞争更为激烈。为此,天数智芯首创了 Dynamic Warp Scheduling 机制,通过动态调度让不同 warp 在资源使用上实现有序协作,避免计算资源闲置,也减少了对同一资源的无序争抢。

这三项设计的出发点本质上都指向相同的目标:高性能与高效率。数据显示,这些创新让天数天枢的效率较当前行业平均水平提升 60%,基于这些效率优势,实现在 DeepSeek V3 场景平均比 Hopper 架构高约 20% 性能。

从这三项设计中可以看出,天数智芯在架构层面的创新,并不是围绕某一个具体模型或算子展开,而是试图打破 GPU 通用范式边界。天数智芯 AI 与加速计算技术负责人单天逸在接受采访时表示,在天数智芯提出 Dynamic Warp Scheduling 设计之前,几乎没有人从调度机制的角度去思考,还能为 MoE 带来哪些性能空间。从更深层次意义来看,这类微架构层面的调度和优化,一直是英伟达、AMD 等巨头保持领先的“内功”,天数智芯在这些单点上的突破,实际上也是国产 GPU 向顶级玩家看齐的重要一步。

提供高质量算力:高效率、可预期、可持续

在天数智芯的架构语境中,回归计算本质并不是一个抽象的口号,而是实现高质量算力的前提条件。只有当 GPU 从底层开始真正对计算负责,高质量算力才成为可能。基于这一判断,天数智芯将高质量算力拆解为三个核心维度:高效率、可预期与可持续。

高效率意味着能为客户创造最优的 TCO(总体拥有成本),节省使用成本;可预期则通过精准的仿真模拟,让客户在拿到芯片、部署算力之前,就能清晰预判最终的性能表现,做到所见即所得;可持续指的是从现在主流的 CNN、RNN,到当下火热的 Transformer,再到未来还未诞生的全新算法,算力始终能无缝适配。

围绕这三个方向,天数智芯在架构及系统设计上,选择从多任务并行处理、长上下文 IX-Attention 模块、IX-SIMU 全栈软件仿真系统以及 IXAI++ 算力系统多个层面同步推进。这几项,其实哪个都值得单独展开探讨。

比如,基于“不设限”的设计理念,在当前 PD 分离的架构下,天数智芯的 GPU 不只做计算,还支撑通信、KV 数据传输这些关键任务,通过打造 Ⅸ 并行任务处理模块,GPU 能精准调度 KV 传输、多路多流、计算与通信等各类任务,让它们并行不冲突。在真实业务场景中,该模块成功帮助头部互联网客户实现了端到端 30% 的性能跃升。

为了提高算力可持续性,天数智芯统一了芯片内、外,来构建算力系统,并通过不断更新的软件栈和软件系统,三类库共同支持和保障多场景的高效运行。其中,AI 库、通讯库(ixccl)、加速计算库是基石,在基石之上,直接支撑各类神经网络模型 CNN、Transformer、LSTM 与高性能计算的各个领域,并以此提供各类 AI 应用,包括支持 AI4Sci 的相关应用,如蛋白质结构预测(AlphaFold)、医疗影像分析(Clara)、气候模拟(Earth2)等,以及量子计算的平台 cudaQ、分子动力学 Gromacs,大规模方程组求解器 HPL 等。

这套算力系统被命名为 IXAI++,寓意为自我迭代,不止于 AI。 其最终的目标是,成为一座连接算法创新与物理世界的桥梁,带领人类科技通往未知探索。

但给业内带来最多惊喜的,是 IX-Attention 模块和 IX-SIMU 全栈软件仿真系统。前者解决的是当前大模型推理中最具代表性的效率难题,后者解决的是企业部署算力系统最头疼的不可控难题。

在大模型推理场景中,长上下文被普遍认为是最具代表性的效率难题之一。即便是在国际主流 GPU 架构上,Attention 的执行效率依然不高,如果不对其进行针对性优化,首字延迟将明显偏高,模型响应速度差,推理成本高昂,最终影响大模型在真实业务中的可用性。

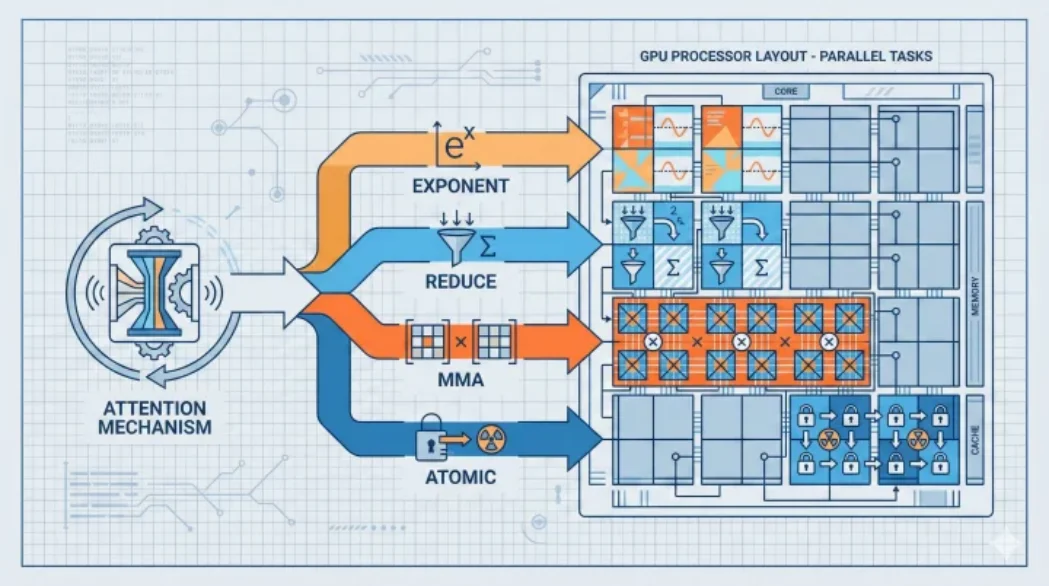

围绕这一痛点,天数智芯设计了 Ⅸ Attention 模块,从底层对 Attention 的执行路径进行重构:Attention 底层涉及 exponent、reduce、MMA、atomic 等多类指令与算子,Ⅸ Attention 模块的核心思路,是将这些分散的组件有机地拼装到一起,如同指挥一支乐队一般,确保多种乐器能够和谐共鸣。

“其中的技术难点在于调度,多种乐器需要同时演奏,任何一个环节拖慢节奏,都会成为整个系统的瓶颈”,单天逸表示,在实际的长上下文推理中,Ⅸ Attention 模块有效改善了 Attention 的执行效率,带来了约 20% 的提升。

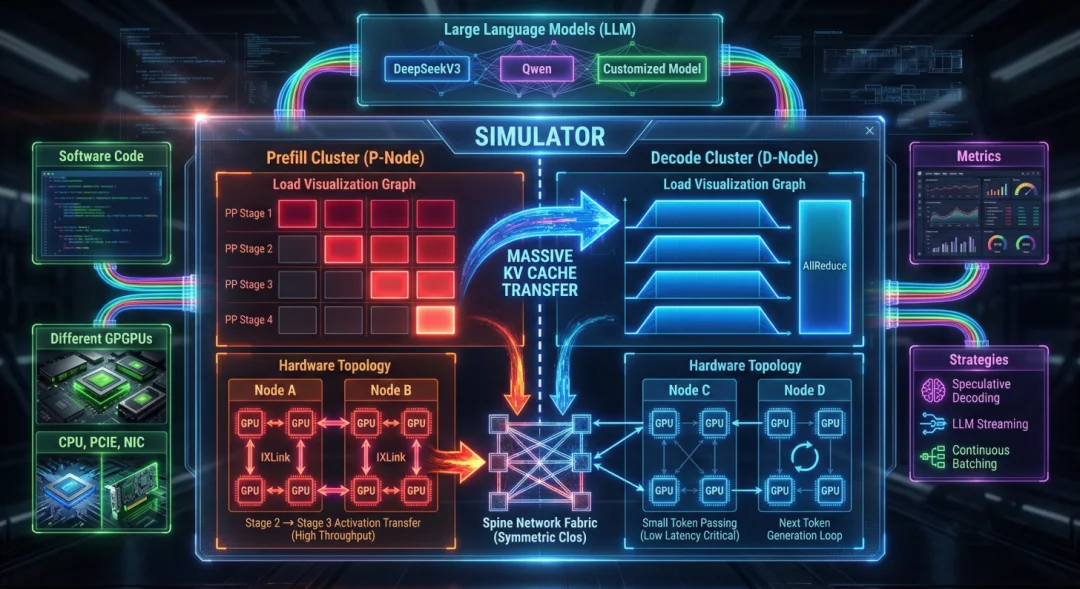

针对企业部署算力系统最头疼的不可控难题,天数智芯搭建了 IX-SIMU 全栈软件仿真系统,这套仿真系统的目标,就是零意外、可预期。通过对芯片等硬件与软件执行策略的联合仿真,能精准输出任意模型的性能表现,提升算力在真实场景中的可控性。

单天逸表示,在算力系统的仿真与评估中,最难建模的是指令级别的硬件行为。IX-SIMU 的核心能力在于,能够对底层指令执行进行精细建模。在实际使用中,用户只需输入软件代码,IX-SIMU 便会自动整合 GPU、CPU、网卡、PCIe 等硬件组件,匹配网络拓扑,再结合软件策略、投机策略、Streaming LLM 策略、前缀匹配等各类策略,最终精准输出 Deepseek、千问等任意模型的性能表现,实现从单卡到万卡集群的 “精密扩展”。

围绕高效率、可预期、可持续三大判断,天数智芯在算力侧从硬件架构到系统设计进行了整体布局,并用未来三代架构路线图提前回答下一个问题:当算力僵化开始掣肘未来计算,架构层还能怎么演进?

2

决定上限的,最终还是应用和生态

架构代表的其实是下限,决定上限的,最终还是应用和生态。数据显示,截至 2025 年年底,天数产品已在互联网、大模型、金融、医疗、教育、交通等超过 20 个行业落地应用,服务客户数量超过 300 家,并通过软硬件协同优化,完成 1000+ 次模型部署,让产品能力真正达到商用级别。

支撑这些场景应用的,早已不是一个产品的能力范畴,而是 “产品 + 解决方案” 双轨模式,这一模式其实与英伟达定位非常相近,聚焦的都是解决方案落地。在大模型深入产业应用的当下,这套组合打法相当务实,毕竟应用落地才是唯一真理,谁能在企业真实业务场景中快速部署、持续稳定运行,谁就能赢得先机。在速度和兼容性上,天数智芯也交出了一份不错的答卷:国内新的大模型发布当天便能跑通,目前已稳定运行 400 余种模型、数千个已有算子与 100 余种定制算子,数千卡集群稳定运行超 1000 天。

在这次发布会上,天数智芯面向物理 AI 场景落地,一口气发布了四款边端算力产品“彤央”系列:包括边端 AI 算力模组 TY1000、TY1100,以及边端 AI 算力终端 TY1100_NX、TY1200。 据了解,“彤央”系列产品的标称算力均为实测稠密算力,覆盖 100T 到 300T 范围。数据显示,在计算机视觉、自然语言处理、DeepSeek 32B 大语言模型、具身智能 VLA 模型及世界模型等多个场景的实测中,彤央 TY1000 的性能全面优于英伟达 AGX Orin。

在发布会中,天数智芯展示了“彤央”系列产品在具身智能、工业智能、商业智能和交通智能四大边端核心领域的落地应用:具身智能领域,为格蓝若机器人提供高算力、低延迟的“大脑”支撑;在工业智能领域,落地园区与产线,推动产线自动化升级;在商业智能领域,瑞幸咖啡数千家门店部署彤央方案,高效处理视频流、挖掘消费数据价值;在交通智能领域,与“车路云一体化”20 个头部试点城市合作,验证车路协同方案。

整体来看,天数智芯走的路线虽然是底层技术自研,但在生态上并非封闭。在生态建设上,天数智芯与硬件厂商、解决方案提供商等多家生态伙伴签署战略合作协议,进一步完善国产 AI 算力生态闭环。通过兼容主流开发生态,持续开放底层能力,降低开发者迁移和使用门槛。未来,天数智芯还会持续增加在生态共建上的资本与人力投入,从应用到芯片与开发者一同优化 AI 应用系统,共同为应用落地提供性能、性价比与生态易用的价值。

从底层架构到产品,从应用到生态,国产算力正在实现完整闭环,这种从芯片到生态的协同能力,不仅让国产算力更可用、更可持续,也为行业探索新模式提供了更多想象空间。

文章来自于“InfoQ”,作者 “凌敏”。