果然,离开了OpenAI,大家都有美好的未来。(doge

从OpenAI离职还不到一个月,推理模型第一人Jerry Tworek就已经火速创业开新局了!

新公司名叫Core Automation,直接剑指「持续学习」领域,目前正计划疯狂筹集10亿美元ing(折合人民币约70亿元)……

虽说,新公司还没研究出个啥东西,但这可一点不影响网友们为昔日的OpenAI老前辈疯狂打call。

这不嘛,已经有朋友觉得,这家公司可能比SSI和Thinky Machines更值得看好了……

推理模型第一人创业,盯上了持续学习

咱先来聊聊Jerry Tworek是谁。

OpenAI的「模型推理能力」能走到今天,Jerry属于绝对绕不开的那个人。

出生在波兰的Jerry,本身就是强理论与数理功底出身。

在华沙大学完成数学硕士学位后,他并没有立刻投身AI研究,而是先去了阿姆斯特丹,从事了几年的量化研究工作。

那段时间里,他每天面对的都是优化问题、噪声数据和有效信号提取这些事儿,每天都在思考如何在不确定环境中做出更好的决策。

也正是在这套问题框架下,Jerry的研究兴趣逐渐转向了强化学习。

2019年加入OpenAI后,Jerry把这一路积累的方法论完整带进了大模型研究中,不仅主导了首个推理模型o1的研发,也深度参与了o3、GPT-4、ChatGPT、Codex等多条核心模型线的构建。

可以说,Jerry是OpenAI内部最早、也最系统性推动「大模型从会生成,走向会推理」的核心人物之一。

而这次出来创业,Jerry选择的切入点,其实是OpenAI留下的一道老题——

模型到底应该怎么学,怎么能让模型「一直学」下去。

之所以这么说,是因为在Jerry看来,OpenAI、Anthropic在内的主流大厂现在的研究重心其实偏了……

他觉得现在市面上的主流模型大多还是「训完就上线」的模式,一旦部署之后,能力基本就固定住了。

可在真实环境里,模型每天都会遇到新情况,怎么把这些新经验真正用起来,目前还没有一条成熟、可靠的路。

(Jerry:学习是永无止境且连续不断的,就算换了AI也是一个理!!!)

而他的新公司Core Automation,就打算搞定这个问题:那就是做一类具备「持续学习」能力的新型AI模型。

让AI模型像人类一样,能够从连续不断的新数据、新任务、新经验中逐步学习新知识,同时尽可能不忘记之前已经掌握的旧知识。

那问题来了,具体咋实现呢?

Jerry的计划是,构建出一套不依赖Transformer的新架构,并尝试将原本分散的训练流程整合为一个连续的系统,使模型在运行过程中也能完成学习。

至于资金层面嘛,Jerry的目标也相当激进——

目前计划筹集5亿到10亿美元,直接按下一代基础模型实验室的规格来起步~

(让我们祝福Jerry,早日找到金主。)

持续学习这条线,已经热起来了

话说回来,Jerry这波创业加高额融资,其实也谈不上多让人意外……

毕竟就在一个月前,他从OpenAI离职时发的那段小作文,就已经提前埋好了伏笔了:

离开OpenAI,去尝试探索一些在OpenAl难以开展的研究领域。

现在公司一成立,「难以开展」这四个字的指向,也算是彻底对上号了。(持续学习:这锅我不背!!!)

那这持续学习,为啥让Jerry这么看重呢?

先说一个最现实的原因:成本和效率。

大家要知道,现在主流大模型这套靠海量静态数据反复预训练的路子,已经是《越走越贵》了。

而持续学习的思路恰好相反!

其认为模型本身可以在真实世界的使用过程中不断吸收新经验,用更少的交互实现明显进步,对训练数据和算力的依赖也会随之降低。

从成本和效率的角度看,这条路确实更划算~

此外,整个行业里一直也有个共识:那就是如果真要实现AGI,模型必须具备「生物」应该具备的能力——

也就是能持续进化、能处理长时序任务、能支撑多模态代理,甚至形成自我优化的循环,而「持续学习」,基本就是这套设想里的关键前提。

这也就不难理解,为啥Jerry哪怕不惜花重金也要去搞了。(是真有前景啊…

当然了,把目光投向持续学习这条路的,并不只有Jerry一个人。

大家熟悉的Ilya创办的SSI公司,走的也是相当接近的方向,而且Ilya本人一直都是持续学习的坚定支持者。

他之前在一次访谈中提到,真正的AGI不应该是那种一次训练就什么都会的静态模型,而是上线之后,能在真实世界里不断学习、持续积累经验的系统,这点和Jerry的理念也算是高度重合了。

不止创业公司,学术界和大厂这边也在同步推进。

比如Google Research,在持续学习方向上已经做出了一些新的尝试。

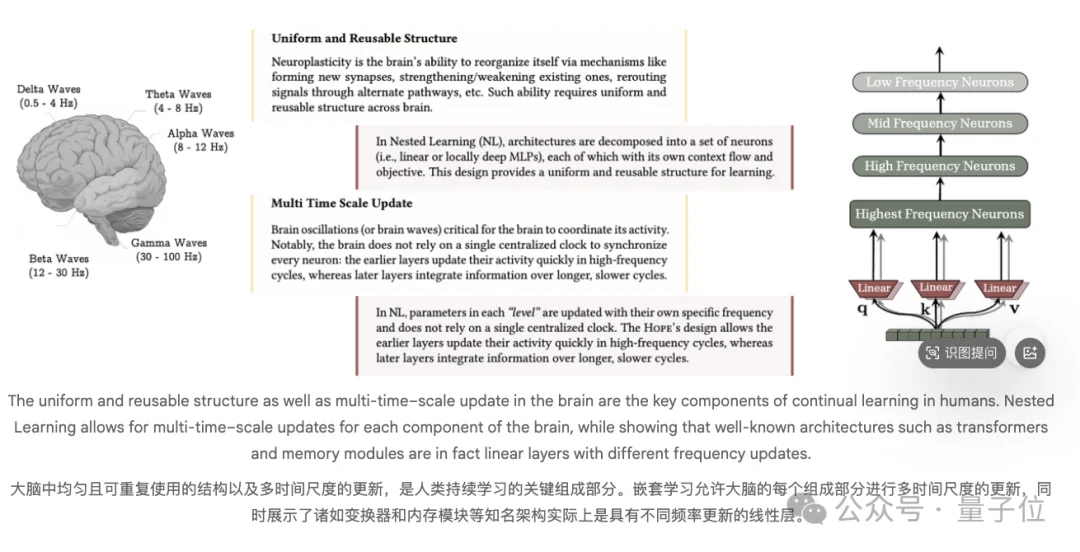

去年年底,他们提出了「Nested Learning」和「Titans」的新思路,把模型看作嵌套的优化过程,引入可学习的长期记忆模块,在推理时融入历史信息,来缓解遗忘问题,让模型具备更强的持续学习能力~

颇值得一提的是,DeepMind的强化学习研究员Ronak Malde前一阵也在社交平台上,针对持续学习的话题发表过一个相当炸裂的判断:

他认为,2026年,将是持续学习元年:

(我们小小期待一下吧)

不管怎么说,还是让我们祝福Jerry早日筹到那10亿美金。

毕竟能让AI“活到老学到老”这件事,确实挺值得大家打call的。(doge

参考链接:

[1]https://www.youtube.com/shorts/AeIsIVgjP4A

[2]https://x.com/AndrewCurran_/status/2016625732940951561?s=20

文章来自于“量子位”,作者 “梦瑶”。